Pythonda tabiiy tillarga ishlov berish kutubxonalari bilan ishlash

![Ramziy NLP (1950-yillar - 1990-yillarning boshi)

Ramziy NLP a sosi Jon Searlning xitoy xonasi tajribasida yaxshi jamlangan:

qoidalar to'plamini (masalan, savollar va mos javoblar bilan xitoycha so'zlashuv

kitobi) hisobga olgan holda, kompyuter tabiiy tilni tushunishga (yoki boshqa NLP

vazifalariga) taqlid qiladi. ushbu qoidalarni o'zi duch keladigan ma'lumotlarga

qo'llash.

1970-yillar : 1970-yillarda ko plab dasturchilar real dunyo ma lumotlariniʻ ʼ

kompyuterda tushunarli ma lumotlarga aylantiruvchi “kontseptual

ʼ ontologiyalar ” ni

yozishni boshladilar . Masalan, MARGIE (Schank, 1975), SAM (Cullingford, 1978),

PAM (Wilensky, 1978), TaleSpin (Meehan , 1976), QALM (Lehnert, 1977), Politics

(Carbonell, 1979) va Plot18 (Lehner18)). Bu vaqt ichida birinchi

ko'plab suhbatdoshlar yozildi (masalan, PARRY ).

1980-yillar : 1980-yillar va 1990-yillarning boshlari NLPdagi ramziy usullarning

gullagan davrini nishonlaydi. Vaqtning asosiy yo'nalishlari qoidalarga asoslangan

tahlil qilish (masalan, generativ grammatikani hisoblash operatsionizatsiyasi

sifatida HPSG ni ishlab chiqish ), morfologiya (masalan, ikki darajali

morfologiya [3]

), semantika (masalan, Lesk algoritmi ), ma'lumotnomalar bo'yicha

tadqiqotlarni o'z ichiga olgan. (masalan, markazlashtirish nazariyasi doirasida ) va

tabiiy tilni tushunishning boshqa sohalari (masalan, ritorik tuzilma

nazariyasida ). Tadqiqotning boshqa yo'nalishlari davom ettirildi,

masalan, Racter va Jabberwacky bilan chatterbotlarni ishlab chiqish. . Muhim voqea

(oxir-oqibat 1990-yillarda statistik burilishga olib keldi) bu davrda miqdoriy

baholashning ortib borayotgan ahamiyati edi.

Statistik NLP (1990-2010 yillar)

1980-yillarga qadar tabiiy tillarni qayta ishlash tizimlarining ko'pchiligi qo'lda

yozilgan qoidalarning murakkab to'plamiga asoslangan edi. 1980-yillarning oxiridan

boshlab, tilni qayta ishlash uchun mashina o'rganish algoritmlarini joriy etish bilan

tabiiy tilni qayta ishlashda inqilob yuz berdi. Bunga hisoblash quvvatining barqaror

o'sishi (qarang. Mur qonuni ) va Xomskiyning tilshunoslik nazariyalari

(masalan , transformatsion grammatika ) hukmronligining asta-sekin kamayishi bilan

bog'liq edi, ularning nazariy asoslari mashinani o'rganish yondashuviga asos

bo'lgan korpus lingvistikasi turini to'xtatdi. tilni qayta ishlashga.

1990-yillar : NLP-da statistik usullar bo'yicha ko'plab dastlabki

muvaffaqiyatlar mashina tarjimasi sohasida , ayniqsa IBM Research

kompaniyasidagi ish tufayli yuzaga keldi. Ushbu tizimlar Kanada

parlamenti va Evropa Ittifoqi tomonidan ishlab chiqarilgan mavjud ko'p

tilli matnli korpusdan foydalanishga muvaffaq bo'ldi. barcha hukumat ishlarini](/data/documents/1e7fd6f8-697e-4d7b-a457-2f0a892b4f2c/page_3.png)

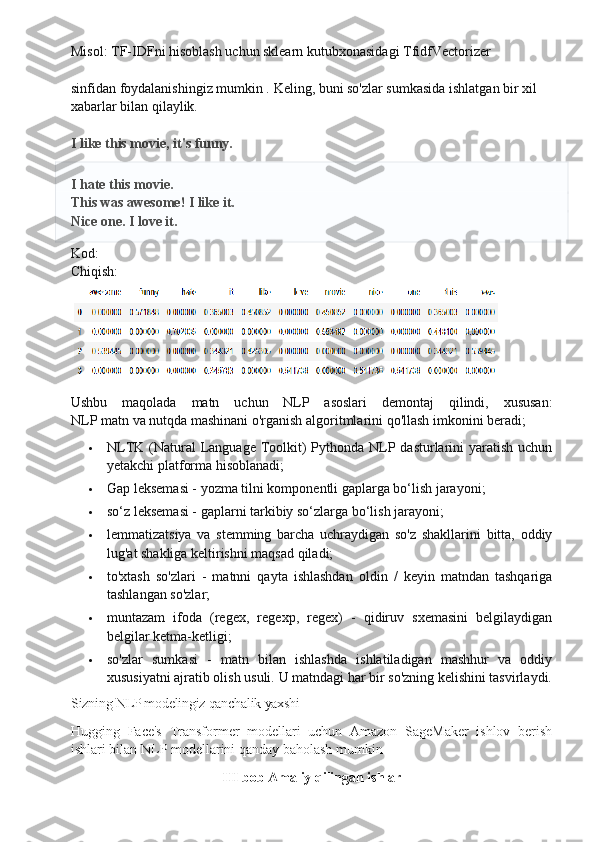

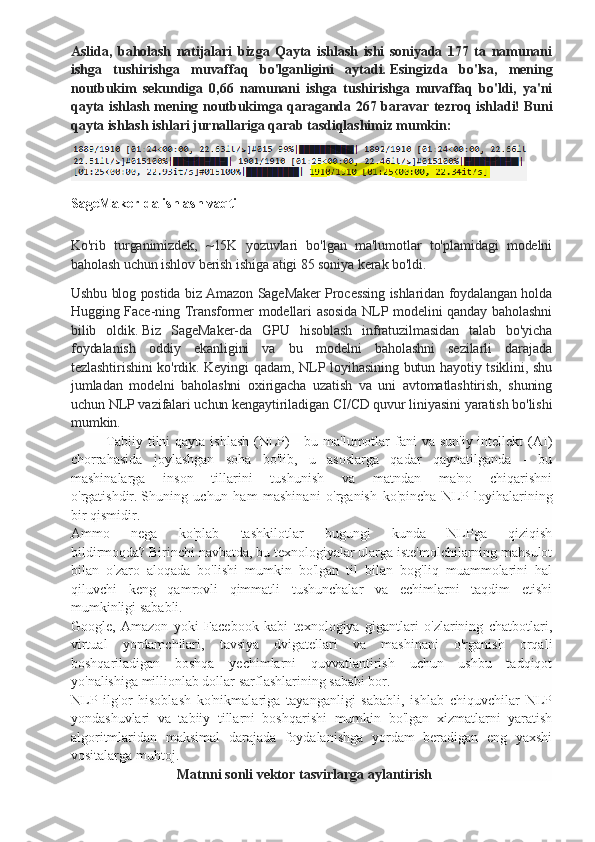

![qulay interfeyslarga, shuningdek tasniflash,tokenizatsiya, stemming, belgilash,

filtrlash va semantik fikrlash uchun matnni qayta ishlash

kutubxonalariga ega . Xo'sh, bu hamjamiyat yordamida ishlab chiqilayotgan bepul

ochiq kodli loyiha. Biz sizga NLP asoslarini ko'rsatish uchun ushbu vositadan

foydalanamiz. Keyingi barcha misollar uchun NLTK allaqachon import qilingan deb

taxmin qilaman buyrug'ibilan qilishingiz mumkin import nltk.

2.2. Matn uchun NLP asoslari

NLTK bilan jumlalarni tokenizatsiya qilish uchun siz usuldan foydalanishingiz

mumkin nltk.sent_tokenize

Natijada biz 3 ta alohida jumlani olamiz.

Backgammon is one of the oldest known board games.

Its history can be traced back nearly 5,000 years to archeological discoveries in

the Middle East.

It is a two player game where each player has fifteen checkers which move

between twenty-four points according to the roll of two dice.

2. So‘zlar orqali tokenizatsiya

So zlar bo yicha tokenizatsiya (ba zan segmentatsiya) gaplarni tarkibiyʻ ʻ ʼ

so zlarga bo lish jarayonidir.

ʻ ʻ Lotin alifbosining ba'zi versiyasini ishlatadigan ingliz

va boshqa ko'plab tillarda bo'shliqlar yaxshi so'z ajratuvchi hisoblanadi.

Biroq, agar biz faqat bo'sh joydan foydalansak, muammolar paydo bo'lishi mumkin -

ingliz tilida qo'shma otlar boshqacha va ba'zan bo'sh joy bilan yoziladi.Va bu erda

yana kutubxonalar bizga yordam beradi. Misol: Oldingi misoldagi gaplarni olib,

usulni qo‘llaymiz mumkin.

Chiqish:

['Backgammon', 'is', 'one', 'of', 'the', 'oldest', 'known', 'board', 'games', '.']

['Its', 'history', 'can', 'be', 'traced', 'back', 'nearly', '5,000', 'years', 'to',

'archeological', 'discoveries', 'in', 'the', 'Middle', 'East', '.']

['It', 'is', 'a', 'two', 'player', 'game', 'where', 'each', 'player', 'has', 'fifteen',

'checkers', 'which', 'move', 'between', 'twenty-four', 'points', 'according', 'to',

'the', 'roll', 'of', 'two', 'dice', '.']](/data/documents/1e7fd6f8-697e-4d7b-a457-2f0a892b4f2c/page_11.png)

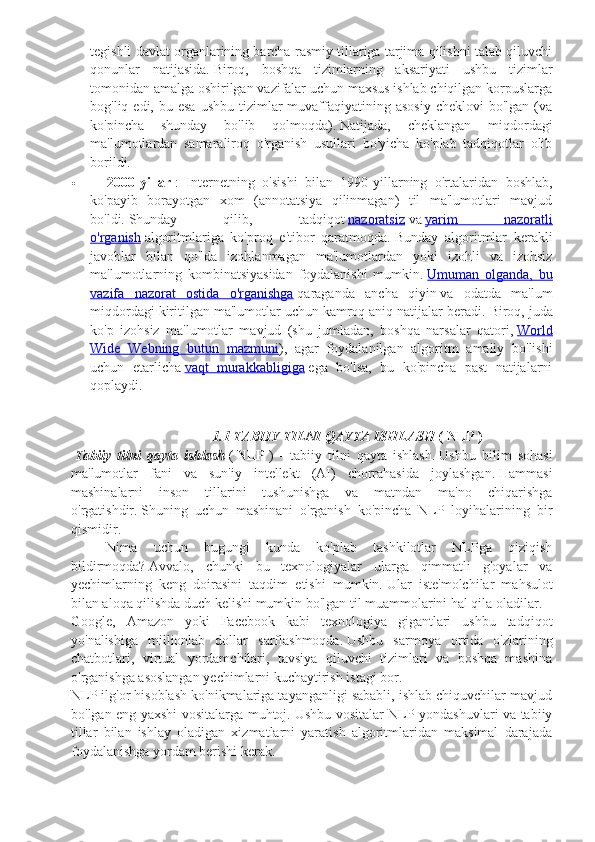

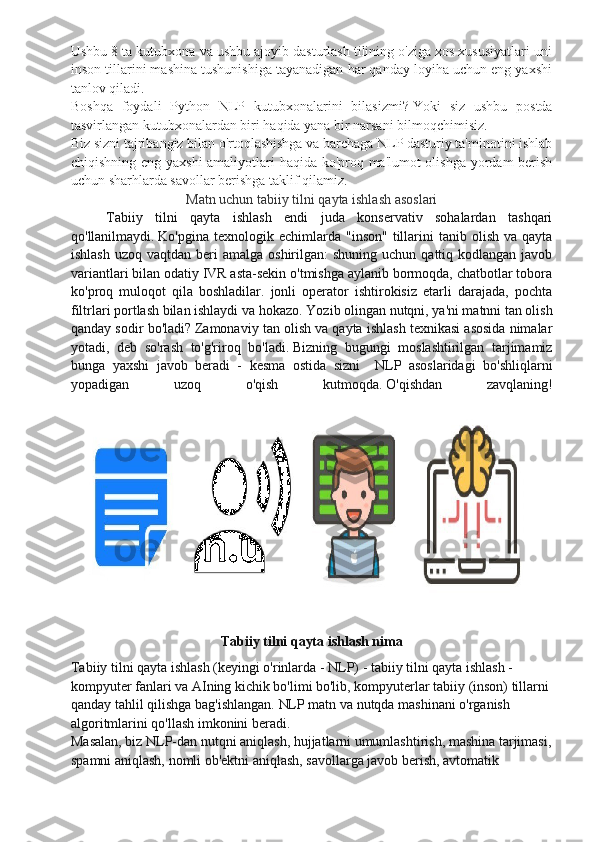

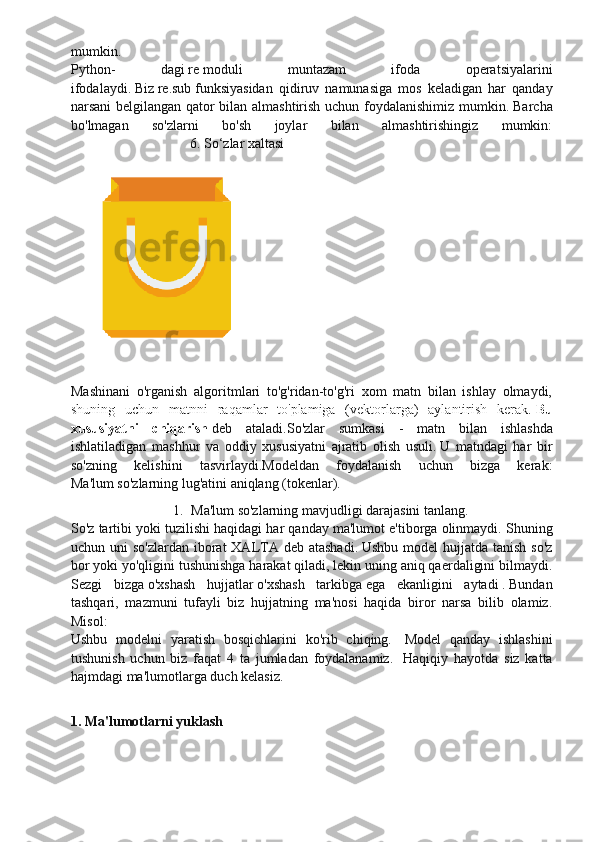

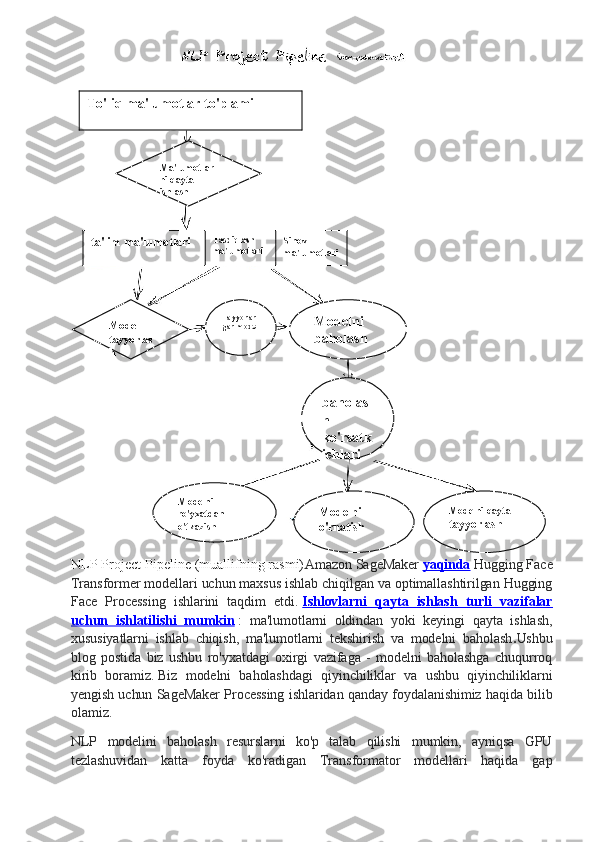

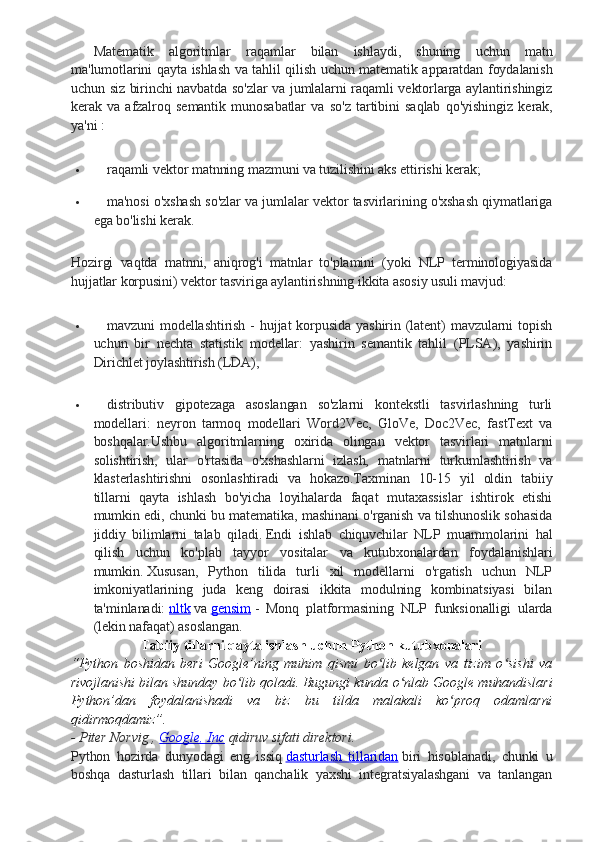

!["should've", 'now', 'd', 'll', 'm', 'o', 're', 've', 'y', 'ain', 'aren', "aren't", 'couldn',

"couldn't", 'didn', "didn't", 'doesn', "doesn't", 'hadn', "hadn't", 'hasn',

"hasn't", 'haven', "haven't", 'isn', "isn't", 'ma', 'mightn', "mightn't", 'mustn',

"mustn't", 'needn', "needn't", 'shan', "shan't", 'shouldn', "shouldn't", 'wasn',

"wasn't", 'weren', "weren't", 'won', "won't", 'wouldn', "wouldn't"]

Qanday qilib jumladan to'xtash so'zlarini olib tashlashni ko'rib chiqing:

Chiqish:

['Backgammon', 'one', 'oldest', 'known', 'board', 'games', '.']

Agar siz ro'yxatni tushunish bilan tanish bo'lmasangiz, bu erda ko'proq ma'lumot

olishingiz mumkin . Xuddi shu natijaga erishishning yana bir usuli:

Biroq, esda tutingki, ro'yxatni tushunish tezroq, chunki ular optimallashtirilgan -

tarjimon tsikl davomida bashoratli naqshni aniqlaydi. Nima uchun ro'yxatni

to'plamga

aylantirdik, deb hayron bo'lishingiz mumkin . To'plam mavhum ma'lumotlar turi

bo'lib, u noyob qiymatlarni aniqlanmagan tartibda saqlashi mumkin. O'rnatilgan

qidiruv ro'yxatdagi qidiruvdan ancha tezroq. Kam sonli so'zlar uchun bu muhim

emas, lekin agar biz ko'p sonli so'zlar haqida gapiradigan bo'lsak, unda to'plamlardan

foydalanish tavsiya etiladi. Agar siz turli xil operatsiyalarni bajarish vaqti haqida bir

oz ko'proq ma'lumotga ega bo'lishni istasangiz, ushbu ajoyib cheat varaqni ko'rib

chiqish.

5. Muntazam iboralar.

Muntazam ifoda (regex, regexp, regex) qidiruv naqshini belgilaydigan belgilar

ketma-ketligidir. Misol uchun:

. - har qanday belgi, yangi qatordan tashqari;

\ w - bitta belgi;

\d - bitta raqam;

\s - bitta bo'sh joy;](/data/documents/1e7fd6f8-697e-4d7b-a457-2f0a892b4f2c/page_14.png)

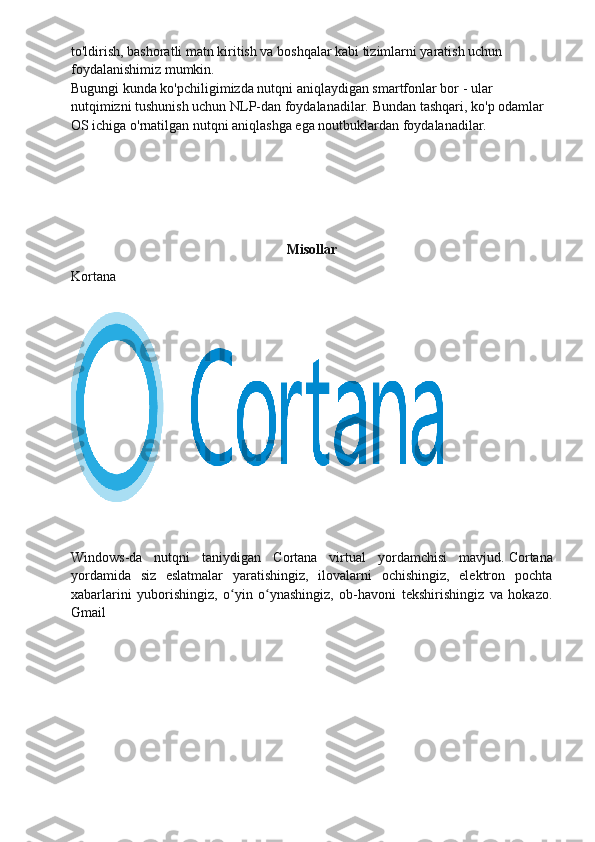

![ \W - bitta EMAS belgi;

\D - bitta raqamli bo'lmagan;

\ S - bitta urinmayapti;

[abc] - belgilangan belgilarning istalganiga a, b yoki c ga mos keladiganini

topadi;

[^abc] - ko'rsatilganlardan tashqari istalgan belgini topadi;

[ag] - a va g orasidagi belgini topadi.

Ushbu maqolada biz quyidagi mavzularni ko'rib chiqamiz:

Tokenizatsiyani taklif qiling.

1. So'zlarni tokenizatsiya qilish.

2. Matnning lemmatizatsiyasi va stemmingi .

3. So'zlarni to'xtating.

4. Muntazam iboralar.

5. So'zlar sumkasi .

6. TF-IDF .

1. Taklif orqali tokenizatsiya

Gapning tokenizatsiyasi (ba'zan segmentatsiya) - yozma tilni tarkibiy gaplarga

bo'lish jarayoni. Fikr juda oddiy ko'rinadi. Ingliz va boshqa ba'zi tillarda har safar

ma'lum bir tinish belgisi - nuqta topilganda biz jumlani ajratib olishimiz mumkin.

Ammo ingliz tilida ham bu vazifa ahamiyatsiz emas, chunki nuqta qisqartmalarda

ham qo'llaniladi. Qisqartmalar jadvali matnni qayta ishlash jarayonida noto'g'ri

joylashtirilgan jumla chegaralarini oldini olish uchun katta yordam berishi

mumkin. Aksariyat hollarda kutubxonalar buning uchun ishlatiladi, shuning uchun

amalga oshirish tafsilotlari haqida juda ko'p tashvishlanishingiz shart emas.

Python hujjatlaridan parcha

Oddiy iboralar (\) maxsus shakllarni ko'rsatish yoki maxsus belgilarga ruxsat

berish uchun teskari chiziqdan foydalanadi. Bu Python-ning teskari chiziqdan

foydalanishiga ziddir: masalan, teskari chiziqni tom ma'noda belgilash uchun qidiruv

namunasi sifatida yozish kerak, chunki regex har bir teskari chiziqdan qochish kerak

bo'lgan '\\\\' ga o'xshash bo'lishi kerak. Yechim qidiruv naqshlari uchun xom satr

belgilaridan foydalanishdir; bilan ishlatilsa, teskari qiyshiq chiziqlar maxsus

ishlanmaydi. Shunday qilib, ikki belgidan iborat satr va bitta belgidan iborat satr

(yangi qator). \\‘r’r”\n”(‘\’ и ‘n’)“\n”

Biz matnimizni filtrlash uchun oddiy iboralardan foydalanishimiz mumkin. Misol

uchun, siz so'z bo'lmagan barcha belgilarni olib tashlashingiz mumkin. Ko'p hollarda

tinish belgilari kerak emas va oddiy iboralar yordamida osongina olib tashlanishi](/data/documents/1e7fd6f8-697e-4d7b-a457-2f0a892b4f2c/page_15.png)

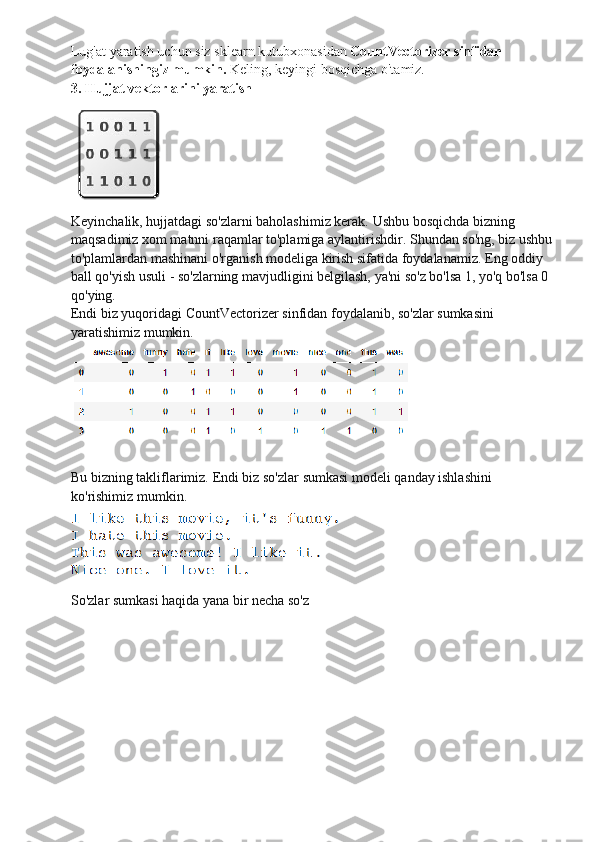

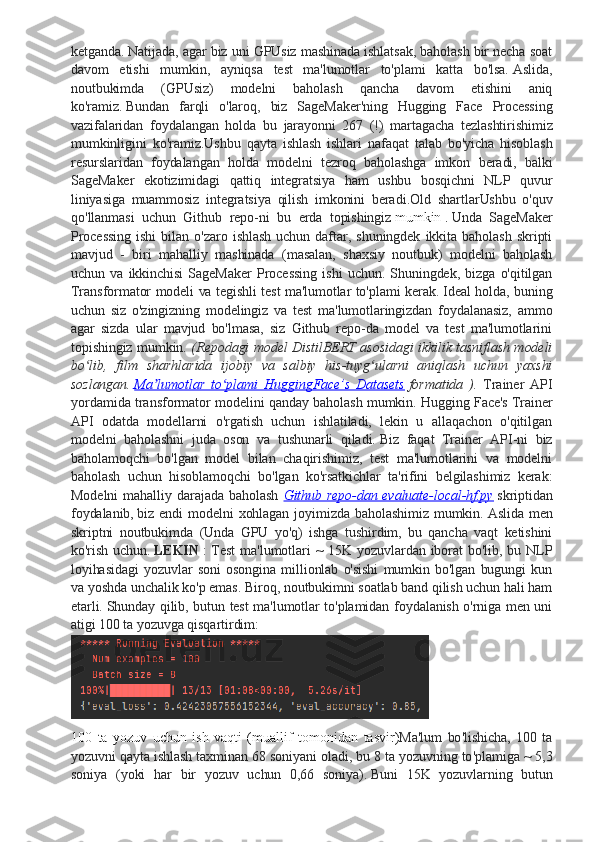

![Tasavvur qilaylik, bu bizning ma'lumotlarimiz va biz uni massiv sifatida

yuklamoqchimiz:

like this movie, it's funny.

I hate this movie.

This was awesome! I like it.

Nice one. I love it.

Buning uchun faylni o'qing va uni satrga bo'ling:

Chiqish:

["I like this movie, it's funny.", 'I hate this movie.', 'This was awesome! I like

it.', 'Nice one. I love it.']

2. Lug‘atga ta’rif bering

Keling, 4 ta yuklangan jumladan barcha noyob so'zlarni to'playmiz, bunda kichik

harflar, tinish belgilari va bitta belgi belgilariga e'tibor bermaslik kerak. Bu bizning

lug'atimiz (ma'lum so'zlar) bo'ladi.](/data/documents/1e7fd6f8-697e-4d7b-a457-2f0a892b4f2c/page_17.png)

MAVZU: Pythonda tabiiy tillarga ishlov berish kutubxonalari bilan ishlash MUNDARIJA: Kirish ……………………………………………………………………………. I.BOB Pythonda tabiiy tillarga NPL ishlov berish kutubxonalari .. …………….. 1.1. Tabiiy tilni qayta ishlash NLP……………………………...…………….. 1.2. NLTK - bu Python-da tasniflash………………………………………..... 1.3.Tabiiy tillarni qayta ishlash uchun Python kutubxonalari………………… II BOB NLP uchun Python-dan foydalaning……………………………………. 2.1. Python kutubxonasi NLTK ………………………………………………. 2.2. Matn uchun tabiiy tilni qayta ishlash asoslari ……………………………. 2.3. Pythonda yozilgan mavzularni modellashtirish , o ' xshashlikni qidirish va tabiiy tilni qayta ishlash uchun kutubxona ………………………………………….. 2.4 Matn uchun NLP asoslari…………………………………………………… III BOB Amaliy qilinga ishlar ……………………………………………………… 3.1 Matnni sonli vektor tasvirlarga aylantirish………………………………… 3.2 Pythonda tabiiy tilarga ishlov berish algoritimlari…………………………. 3.3 Pythonda tabiiy tillarga bilan ishlash uchun python codlari……………….. Xulosa…………...…………………………………………………………………… Foydalanilgan adabiyotlar ro’yxati……...…………………………………………

KIRISH Insoniyat o'zining rivojlanishi tarixi haqida moddiy quvvat va axborotlarni o'zlashtirib kelgan. Bu qilish butun bir davrlari shu bosqichning ilg' yoki texnologiya nomi bilan atalgan. Masalan:"tosh asr” – mexnat quroli yasash uchun toshga berish texnologiyasini egallash bochqichi, “kitob chop etish asri”-axborotni tarqatishni yangi usulini o'zlashtirish bosqichi, “elektr asri” - quvvatning yangi turlarini o'zlashtirish bosqichi shular jumlasidandir. Informatika axboltaborotlarni EXM yordam tasvirlash, saqlab turish, amalga oshirishva hisoblanadi ishlov berish usullarini o'rganadigan fandir. EXMlarni ishlab chiqarish chiqish va undanqidiruv soxasida katta yutuqlarga erishilgan olim VMGlushkov ta'biri bilan aytsak: yangi kabir keyin texnik jixatdan tomonidan mamlakatlarda tegishli axborot EXM xotirasida bo'ladi. XXI asr boshlarida ana shu axborotlardan yuborishni bilmagan kishi, XX asr davom etish va mahsulotni bilmagan odamga o'xshab qoladi. Bundan kelib chiqqan xolda “Informatika” fanini o'rganish ikkinchi savodxonlik bilan tengdir. Davom etish vamahsulotni bilmaganodamga o'xshab qoladi. Bundan kelib chiqqan xolda “Informatika” fanini o'rganish ikkinchi savodxonlik bilan tengdir. Tabiiy tilni qayta ishlash (NLP) - bu ma'lumotlar fani va sun'iy intellekt (AI) yaqinlashuvida joylashgan soha bo'lib, u asoslarga qisqartirilganda - bu mashinalarga inson lahjalarini tushunish va matndan ma'no chiqarishni o'rgatish bilan bog'liq. Shu sababli sun'iy intellekt NLP loyihalari uchun muntazam ravishda zarurdir. Buning sababi nimada, nega ko'p kompaniyalar NLP haqida qayg'uradilar. Asosan, ushbu yutuqlar ularga keng qamrovli bilim va kelishuvlarni taqdim etishi mumkinligi sababli, xaridorlar buyum bilan hamkorlik qilishda duch kelishi mumkin bo'lgan til bilan bog'liq muammolarni hal qiladi. Tabiiy tilni qayta ishlash 1950-yillarga borib taqaladi. 1950 yilda Alan Turing " Hisoblash mashinalari va razvedka " nomli maqolani nashr etdi, unda hozirda Tyuring testi deb ataladigan narsa aql mezoni sifatida taklif qilingan, ammo o'sha paytda bu sun'iy intellektdan alohida muammo sifatida ifodalanmagan edi. Taklif etilayotgan test tabiiy tilni avtomatlashtirilgan talqin qilish va yaratishni o'z ichiga olgan vazifani o'z ichiga oladi.

Ramziy NLP (1950-yillar - 1990-yillarning boshi) Ramziy NLP a sosi Jon Searlning xitoy xonasi tajribasida yaxshi jamlangan: qoidalar to'plamini (masalan, savollar va mos javoblar bilan xitoycha so'zlashuv kitobi) hisobga olgan holda, kompyuter tabiiy tilni tushunishga (yoki boshqa NLP vazifalariga) taqlid qiladi. ushbu qoidalarni o'zi duch keladigan ma'lumotlarga qo'llash. 1970-yillar : 1970-yillarda ko plab dasturchilar real dunyo ma lumotlariniʻ ʼ kompyuterda tushunarli ma lumotlarga aylantiruvchi “kontseptual ʼ ontologiyalar ” ni yozishni boshladilar . Masalan, MARGIE (Schank, 1975), SAM (Cullingford, 1978), PAM (Wilensky, 1978), TaleSpin (Meehan , 1976), QALM (Lehnert, 1977), Politics (Carbonell, 1979) va Plot18 (Lehner18)). Bu vaqt ichida birinchi ko'plab suhbatdoshlar yozildi (masalan, PARRY ). 1980-yillar : 1980-yillar va 1990-yillarning boshlari NLPdagi ramziy usullarning gullagan davrini nishonlaydi. Vaqtning asosiy yo'nalishlari qoidalarga asoslangan tahlil qilish (masalan, generativ grammatikani hisoblash operatsionizatsiyasi sifatida HPSG ni ishlab chiqish ), morfologiya (masalan, ikki darajali morfologiya [3] ), semantika (masalan, Lesk algoritmi ), ma'lumotnomalar bo'yicha tadqiqotlarni o'z ichiga olgan. (masalan, markazlashtirish nazariyasi doirasida ) va tabiiy tilni tushunishning boshqa sohalari (masalan, ritorik tuzilma nazariyasida ). Tadqiqotning boshqa yo'nalishlari davom ettirildi, masalan, Racter va Jabberwacky bilan chatterbotlarni ishlab chiqish. . Muhim voqea (oxir-oqibat 1990-yillarda statistik burilishga olib keldi) bu davrda miqdoriy baholashning ortib borayotgan ahamiyati edi. Statistik NLP (1990-2010 yillar) 1980-yillarga qadar tabiiy tillarni qayta ishlash tizimlarining ko'pchiligi qo'lda yozilgan qoidalarning murakkab to'plamiga asoslangan edi. 1980-yillarning oxiridan boshlab, tilni qayta ishlash uchun mashina o'rganish algoritmlarini joriy etish bilan tabiiy tilni qayta ishlashda inqilob yuz berdi. Bunga hisoblash quvvatining barqaror o'sishi (qarang. Mur qonuni ) va Xomskiyning tilshunoslik nazariyalari (masalan , transformatsion grammatika ) hukmronligining asta-sekin kamayishi bilan bog'liq edi, ularning nazariy asoslari mashinani o'rganish yondashuviga asos bo'lgan korpus lingvistikasi turini to'xtatdi. tilni qayta ishlashga. 1990-yillar : NLP-da statistik usullar bo'yicha ko'plab dastlabki muvaffaqiyatlar mashina tarjimasi sohasida , ayniqsa IBM Research kompaniyasidagi ish tufayli yuzaga keldi. Ushbu tizimlar Kanada parlamenti va Evropa Ittifoqi tomonidan ishlab chiqarilgan mavjud ko'p tilli matnli korpusdan foydalanishga muvaffaq bo'ldi. barcha hukumat ishlarini

tegishli davlat organlarining barcha rasmiy tillariga tarjima qilishni talab qiluvchi qonunlar natijasida. Biroq, boshqa tizimlarning aksariyati ushbu tizimlar tomonidan amalga oshirilgan vazifalar uchun maxsus ishlab chiqilgan korpuslarga bog'liq edi, bu esa ushbu tizimlar muvaffaqiyatining asosiy cheklovi bo'lgan (va ko'pincha shunday bo'lib qolmoqda). Natijada, cheklangan miqdordagi ma'lumotlardan samaraliroq o'rganish usullari bo'yicha ko'plab tadqiqotlar olib borildi. 2000-yillar : Internetning o'sishi bilan 1990-yillarning o'rtalaridan boshlab, ko'payib borayotgan xom (annotatsiya qilinmagan) til ma'lumotlari mavjud bo'ldi. Shunday qilib, tadqiqot nazoratsiz va yarim nazoratli o'rganish algoritmlariga ko'proq e'tibor qaratmoqda. Bunday algoritmlar kerakli javoblar bilan qo'lda izohlanmagan ma'lumotlardan yoki izohli va izohsiz ma'lumotlarning kombinatsiyasidan foydalanishi mumkin. Umuman olganda, bu vazifa nazorat ostida o'rganishga qaraganda ancha qiyin va odatda ma'lum miqdordagi kiritilgan ma'lumotlar uchun kamroq aniq natijalar beradi. Biroq, juda ko'p izohsiz ma'lumotlar mavjud (shu jumladan, boshqa narsalar qatori, World Wide Webning butun mazmuni ), agar foydalanilgan algoritm amaliy bo'lishi uchun etarlicha vaqt murakkabligiga ega bo'lsa, bu ko'pincha past natijalarni qoplaydi. 1.1 TABIIY TILNI QAYTA ISHLASH ( NLP ) Tabiiy tilni qayta ishlash ( NLP ) - tabiiy tilni qayta ishlash. Ushbu bilim sohasi ma'lumotlar fani va sun'iy intellekt (AI) chorrahasida joylashgan. Hammasi mashinalarni inson tillarini tushunishga va matndan ma'no chiqarishga o'rgatishdir. Shuning uchun mashinani o'rganish ko'pincha NLP loyihalarining bir qismidir. Nima uchun bugungi kunda ko'plab tashkilotlar NLPga qiziqish bildirmoqda? Avvalo, chunki bu texnologiyalar ularga qimmatli g'oyalar va yechimlarning keng doirasini taqdim etishi mumkin. Ular iste'molchilar mahsulot bilan aloqa qilishda duch kelishi mumkin bo'lgan til muammolarini hal qila oladilar. Google, Amazon yoki Facebook kabi texnologiya gigantlari ushbu tadqiqot yo'nalishiga millionlab dollar sarflashmoqda. Ushbu sarmoya ortida o'zlarining chatbotlari, virtual yordamchilari, tavsiya qiluvchi tizimlari va boshqa mashina o'rganishga asoslangan yechimlarni kuchaytirish istagi bor. NLP ilg'or hisoblash ko'nikmalariga tayanganligi sababli, ishlab chiquvchilar mavjud bo'lgan eng yaxshi vositalarga muhtoj. Ushbu vositalar NLP yondashuvlari va tabiiy tillar bilan ishlay oladigan xizmatlarni yaratish algoritmlaridan maksimal darajada foydalanishga yordam berishi kerak.

1.2 NATURAL LANGUAGE TOOLKIT (NLTK) NLTK Python - da tasniflash , stemming , teglash , tahlil qilish va semantik fikrlash kabi vazifalarni qo ' llab - quvvatlaydigan muhim kutubxonadir . Bu tabiiy tilni qayta ishlash va mashinani o'rganish uchun asosiy vositangiz. Bugungi kunda u NLP va mashinani o'rganishni endigina boshlayotgan Python dasturchilari uchun ta'lim asosi bo'lib xizmat qiladi. Kutubxona Pensilvaniya universitetida Stiven Bird va Edvard Lauper tomonidan ishlab chiqilgan. U NLP ning ilg'or tadqiqotlarida muhim rol o'ynadi. NLTK, boshqa Python kutubxonalari va vositalari bilan bir qatorda, endi butun dunyo universitetlari tomonidan o'z o'quv dasturlarida qo'llaniladi. Kutubxona juda ko'p qirrali, ammo (va buni tan olish kerak!) uni tabiiy tilni qayta ishlash uchun ishlatish qiyin. NLTK juda sekin bo'lishi mumkin va tez rivojlanayotgan sanoat foydalanish talablariga javob bermaydi . O'rganish egri chizig'i juda keskin, ammo ishlab chiquvchilar ushbu foydali kitob kabi resurslardan foydalanishlari mumkin . Unda siz ushbu asboblar to'plami qo'llab- quvvatlaydigan tilni qayta ishlash vazifalari ortidagi tushunchalar haqida ko'proq bilib olasiz. 2. Textblo TextBlob Python-da NLP sayohatini boshlagan ishlab chiquvchilar uchun majburiydir. NLP ga birinchi kirish uchun ideal. TextBlob yangi boshlanuvchilarga his-tuyg'ularni tahlil qilish, POS belgilarini belgilash yoki ism iboralarini chiqarish kabi asosiy NLP vazifalarini o'zlashtirishga yordam beradigan oddiy interfeys bilan ta'minlaydi. Python bilan NLPga birinchi qadamlarini qo'ymoqchi bo'lgan har bir kishi ushbu kutubxonadan foydalanishi kerak deb hisoblaymiz. Prototiplarni loyihalashda juda foydali. Biroq, u NLTK ning asosiy kamchiliklarini ham meros qilib oldi. Ishlab chiqarishda NLP Python-dan foydalanish talablariga duch kelgan ishlab chiquvchilarga samarali yordam berish uchun ushbu kutubxona juda sekin. 3. Asosiy NLP Ushbu kutubxona Stenford universitetida ishlab chiqilgan va Java tilida yozilgan. Biroq, u ko'plab tillar, jumladan Python uchun o'ramlar bilan birga keladi, bu esa Python-da tabiiy tilni qayta ishlashda o'zini sinab ko'rmoqchi bo'lgan ishlab chiquvchilar uchun foydali bo'ladi . CoreNLP ning eng katta foydasi nimada ? Kutubxona haqiqatan ham tez va mahsulot ishlab chiqish muhitida yaxshi ishlaydi. Bundan tashqari, CoreNLP ning ba'zi komponentlari NLTK bilan birlashtirilishi mumkin, bu muqarrar ravishda ikkinchisining samaradorligini oshiradi. 4. Gensim