Big Data va ma`lumotlar tahlili faniga kirish, fanning maqsadi, asosiy tushunchalar tariflari. Data Scientist ma’lumotlar tahlilchisi, ma’lumotlar muhandisi, mashinali o`qitish muhandisi

“ Big Data va ma`lumotlar tahlili faniga kirish, fanning maqsadi, asosiy tushunchalar tariflari. Data Scientist : ma’lumotlar tahlilchisi, ma’lumotlar muhandisi, mashinali o`qitish muhandisi ” mavzusida Reja: 1. Big Data(katta ma'lumotlar)ning 8 eng asosiy atamalari 2. Big-Data texnologiyasi. Katta ma’lumotlarni tahlil qilish tizimlari. 3. Katta ma’lumotlar va biznes. Katta ma’lumotlarni tahlil qilish texnikasi. 4. Katta ma’lumotlar va ma’lumotlarni qayta ishlash. Katta ma’lumotlar mashinasi.

1. Big Data (katta ma'lumotlar)ning 8 eng asosiy atamalari Big data ( katta ma'lumotlar ) - juda katta hajmdagi bir jinsli bo'lmagan va tez tushadigan raqamli ma'lumotlar bo'lib, ularni odatiy usullar bilan qayta ishlab bo'lmaydi. Ba'zi hollarda, katta ma'lumotlar tushunchasi bilan birga shu ma'lumotlarni qayta ishlash ham tushuniladi. Asosan, analiz obyekti katta ma'lumotlar deb ataladi. Big data atamasi 2008-yilda dunyoga kelgan. Nature jurnali muharriri Klifford Linch dunyo ma'lumotlar hajmining juda tez sur'atda o'sishiga bag'ishlangan maxsus sonida big data atamasini qo'llagan. Biroq, katta ma'lumotlar avval ham bo'lgan. Mutaxassislarning fikricha, kuniga 100 gb dan ko'p ma'lumot tushadigan oqimlarga big data deb aytilar ekan. Katta ma'lumotlarni analiz qilish, inson his etish imkoniyatidan tashqarida bo'lgan qonuniylatlarni aniqlashda yordam beradi. Bu esa kundalik hayotimizdagi barcha sohalar, hukumatni boshqarish, tibbiyot, telekommunikatsiya, moliya, transport, ishlab chiqarish va boshqa sohalarni yanada yaxshilash, ularning imkoniyatlarini oshirish, muommolarga muqobil yechimlar izlab topish imkonini yaratadi. Data lake ( ma'lumotlar ko'li ) - qayta ishlanmagan katta ma'lumotlar ombori. "Ko'l" har xil manbalardan kelgan, har xil formatda bo'lgan ma'lumotlarni saqlaydi. Bu esa odatiy relatsion ma'lumotlar omborida ma'lumotlarni aniq struktura asosida saqlashdan ko'ra arzonroqqa tushadi. Ma'lumotlar ko'li, ma'lumotlarni boshlang'ich holatida analiz qilish imkonini beradi. Bundan tashqari, "ko'l"lardan bir vaqtni o'zida bir nechta ishchilar foydalanishlari mumkin. Data science ( ma'lumotlar haqidagi fan ) - analiz muommolarini , ma'lumotlarni qayta ishlash va ularni raqamli ko'rinishda taqdim etishni o'rganadigan fan.

Bu atama dunyoga kelgan vaqt 1974-yil hisoblanadi. O'sha yili Daniyalik informatik, Peter Naur "A Basic Principle of Data Science" nomli kitobini chop ettirgan. 2010-yillar boshida katta ma'lumotlarni tarqalishi natijasida bu yo'nalish juda foydali va kelajagi bor biznesga aylandi. Ushanda katta ma'lumotlar bilan ishlaydigan mutaxassislarga talab juda oshib ketdi. Data science tushunchasiga ma'lumotlar omborini loyihalash va raqamlangan ma'lumotlarni qayta ishlashning barcha metodlari kiradi. Ko'plab mutaxassislar fikricha, aynan data science big dataning biznes nuqtai nazaridan hozirgi zamonoviy o'rindoshi hisoblanadi. Data mining ( ma'lumotlarni topish ) - biron qonuniyatni topish maqsadida ma'lumotlarni intellektual analiz qilishga aytiladi. Isroillik matematik Grigoriy Pyatetskiy-Shapiro 1989-yilda bu atamani fanga kiritgan. Texnologiyalar, avvalari noma'lum va foydali bo'lgan qayta ishlanmagan(hom) ma'lumotlarni topish jarayoniga data mining(ma'lumotlarni topish) deyiladi. Data mining metodlari ma'lumotlar ombori, statistika va sun'iy intellekt tutashgan nuqtada joylashadi. Machine learning ( mashinali o'qitish ) - o'zi o'rganadigan dasturlar yaratish amaliyoti va nazariyasi, sun'iy intellektning katta qismi. Dasturchilar o'z algoritmlariga xususiy hollarda umumiy qonuniyatlarni aniqlashni o'rgatishadi. Natijada, kompyuter, inson avvaldan ko'rsatib o'tgan buyruqlaridan emas, balki, o'z shaxsiy malakasidan kelib chiqib qaror qabul qiladi. Bunday o'qitishning juda ko'p metodlari data mining'ga oid bo'lishi mumkin. Mashinali o'qitishga birinchi tarifni 1959-yilda amerikalik informatik Artur Samuel bergan. U sun'iy intellekt elementlariga ega bo'lgan shashka o'yini, dunyoda birinchi o'zi o'rganadigan dasturni yaratgan. Deep learning ( chuqur o'qitish ) - yanada murakkab va yanada mustaqil bo'lgan o'zi o'qidigan dasturlar yaratadigan mashinali o'qitish turi. Oddiy mashinali o'qitish hollarida boshqariladigan malaka yordamida kompyuter

bilimlarni aniqlab oladi: dasturchi algoritmga ma'lum misollarni ko'rsatadi, xatolarni qo'lda to'g'rilaydi. Deep learningda esa, tizim o'zi o'z funksiyalarini loyihalaydi, ko'p darajali hisob-kitoblar amalga oshiradi va atrof-muhit haqida xulosalar qiladi. Odatda chuqur o'qitishni neyron tarmoqlarga tadbiq qilishadi. Bu texnologiya asosan rasmlarni qayta ishlashda, nutqni tanishda, neyromashina tarjima, farmatsevtikadagi hisoblashlarda va boshqa zamonaviy texnologiyalarda qo'llaniladi. Asosan Google, facebook va Baidu tomonidan loyihalarga tadbir qilinadi. Sun'iy neyron tarmog'i - oddiy protsessorlar(sun'iy neyronlar) birlashtirilgan tizimi bo'lib, insonning nerv tizimini imitatsiya qiladi. Bunday struktura evaziga, neyron tarmoqlari dasturlanmaydi, ular o'qitishadi. Huddi haqiqiy neyronlar kabi, protsessorlar signallarni oddiygina qabul qilishadi va boshqa protsessorlarga o'zatishadi. Shu bilan birga, boshqa butun tizim algoritmlar bajara olmaydigan murakkab topshiriqlarni bajaradi. 1943-yilda amerikalik olimlar Uorren Makkalok va Uolter Pittslar sun'iy neyron tarmog'i tushunchasini fanga kiritishgan. Business intelligence ( biznes-analitika ) - aniq strukturaga ega bo'lmagan juda katta hajmdagi ma'lumotlarni qayta ishlash natijasida muqobil biznes yechimlar izlashga aytiladi. Effektiv biznes-analitika ichki va tashqi ma'lumotlarni analiz qiladi - ham bozor axborotlarini, ham mijoz-kompaniyaning hisobotlarini hisobga oladi. Bu biznesni butunlay tushunishga yordam beradi, shu bilan birga, strategik va operatsion qarorlar qabul qilishga zamin yaratadi(mahsulot narxini aniqlashda, kompaniya rivojlanishining asosiy yo'nalishlarini belgilab olishda). Bu atama 1958-yilda IBM taqdiqotchisi Xans Piter Lun maqolasida birinchi bo'lib ko'rsatilgan. 1996-yilda axborot texnologiyalari bozorini o'rganishga asoslangan Gartner analitik agentligi business intelligence tarkibiga data mining metodikasini ham qo'shgan.

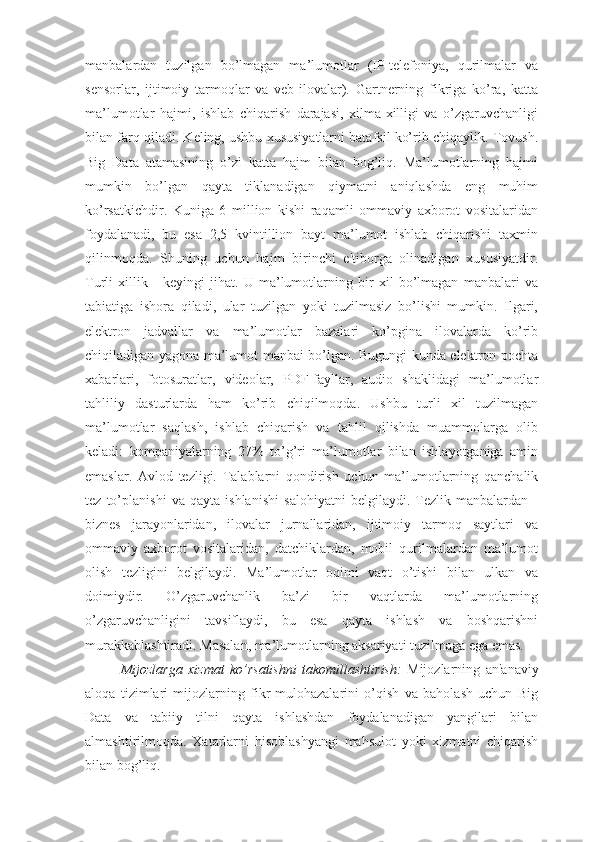

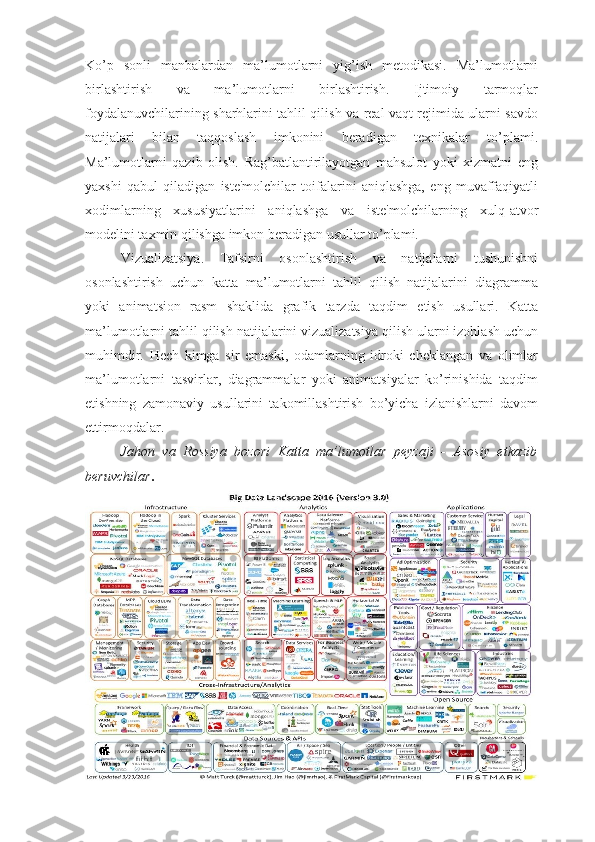

2. Big-Data texnologiyasi. Katta ma’lumotlarni tahlil qilish tizimlari. 2018 yil o'rtalariga kelib Vikipediya Big Data atamasiga quyidagi ta'rifni berdi: "Katta ma'lumotlar - bu 2000-yillarning oxirida paydo bo'lgan va ma'lumotlar bazasini boshqarishning an'anaviy tizimlari va Business Intelligence klassining echimlariga alternativa bo'lgan, gorizontal miqyosda kengaytiriladigan dasturiy vositalar yordamida samarali ishlov beriladigan juda katta hajmli va sezilarli tuzilmalarning ma'lumotlari". Ko'rib turganingizdek, ushbu ta'rifda "ulkan", "ahamiyatli", "samarali" va "alternativ" kabi noaniq atamalar mavjud. Hatto ismning o'zi ham juda subyektivdir. IBS kompaniyasi tahlilchilari "ma'lumotlarning butun dunyo hajmini" quyidagi ko'rsatkichlar bo'yicha baholadilar: 2003 - 5 ekzabayt ma'lumotlar (1 EB = 1 milliard gigabayt) 2008 yil - 0,18 zettabayt (1 zb = 1024 ekzabayt) 2015 yil - 6,5 zettabaytdan yuqori 2020 - 40-44 zettabayt (prognoz) 2025 yil - bu hajm 10 baravar ko'payadi. Hisobotda shuningdek, ma'lumotlarning aksariyati oddiy iste'molchilar tomonidan emas, balki korxonalar tomonidan yaratilmasligi ta'kidlanadi (Things Industrial Internet-ni eslang). Bundan tashqari, siz jurnalistlar va marketologlarning aniq fikriga mos keladigan sodda ta'rifdan foydalanishingiz mumkin. "Katta ma'lumotlar - bu uchta operatsiyani bajarish uchun mo'ljallangan texnologiyalarning birikmasi: Bundan tashqari, 2015 yil oktyabr oyida Gartner Big Data-ni mashhur tendentsiyalar ro'yxatidan chiqarib tashladi. Kompaniya tahlilchilari o'z qarorlarini "katta ma'lumotlar" tushunchasi korxonalarda allaqachon faol qo'llaniladigan, qisman boshqa mashhur sohalar va tendentsiyalar bilan bog'liq bo'lgan va kundalik ishlaydigan vositaga aylangan ko'plab texnologiyalarni o'z ichiga olganligi bilan izohlashdi.