Nazorat ostida o’qitish algoritmlari. Ridge Regression

Mav zu:Nazorat ost ida o’qit ish algorit mlari. Ridge Regression REJ A: 1 A mal qilish k erak bo'lgan qadamlar 2 A lgorit mni t anlash 3 Tarafk ashlik v a dispersiy a o'rt asidagi k elishuv

Nazorat ostida o'rganish (SL) - bu mavjud ma'lumotlar belgilangan misollardan iborat bo'lgan vazifalar uchun mashinani o'rganish paradigmasi, ya'ni har bir ma'lumot nuqtasida ob'ektlar (kovariatlar) va ular bilan bog'liq yorliq mavjud. Nazorat qilinadigan o'rganish algoritmlarining maqsadi i / u juftliklari misollari asosida ob'ekt vektorlarini (kirish ma'lumotlarini) yorliqlarga (chiqishlarga) xaritalaydigan funktsiyani o'rganishdir.U funktsiyani a dan chiqaradi boshqaruv signali kirish ob'ekti (odatda vektor) va kerakli chiqish qiymatidan iborat (shuningdek, deyiladi) juftlik nazorat ostida o'qitishda har bir misol ifodalaydi .o'quv misollari to'plamidan iborat o'quv ma'lumotlari, etiketlangan o'quv misollari to'plamidan tashkil topgan yorliqli o'quv ma'lumotlari. Nazorat ostida o'qitishda har bir misol kirish ob'ekti (odatda vektor) va kerakli chiqish qiymatidan (boshqaruv signali deb ham ataladi) iborat juftlikdir. A mal qilish k erak bo'lgan qadamlar Ushbu nazorat ostida o'rganish muammosini hal qilish uchun quyidagi amallarni bajarish kerak: 1.O'quv misollarining turini aniqlang. Boshqa hech narsa qilishdan oldin, foydalanuvchi qaysi ma'lumotlar o'quv to'plami sifatida ishlatilishini hal qilishi kerak. Masalan, qo'l yozuvi tahlilida bu bitta qo'lda yozilgan belgi, butun qo'lda yozilgan so'z, qo'lda yozilgan matnning butun jumlasi yoki ehtimol qo'lda yozilgan matnning butun paragrafi bo'lishi mumkin. 2.O'quv to'plamini to'plang. O'quv to'plami funktsiyadan haqiqiy foydalanishning vakili bo'lishi kerak. Shunday qilib, kirish ob'ektlari to'plami yig'iladi, shuningdek, inson mutaxassislari yoki o'lchovlardan tegishli chiqishlar yig'iladi.

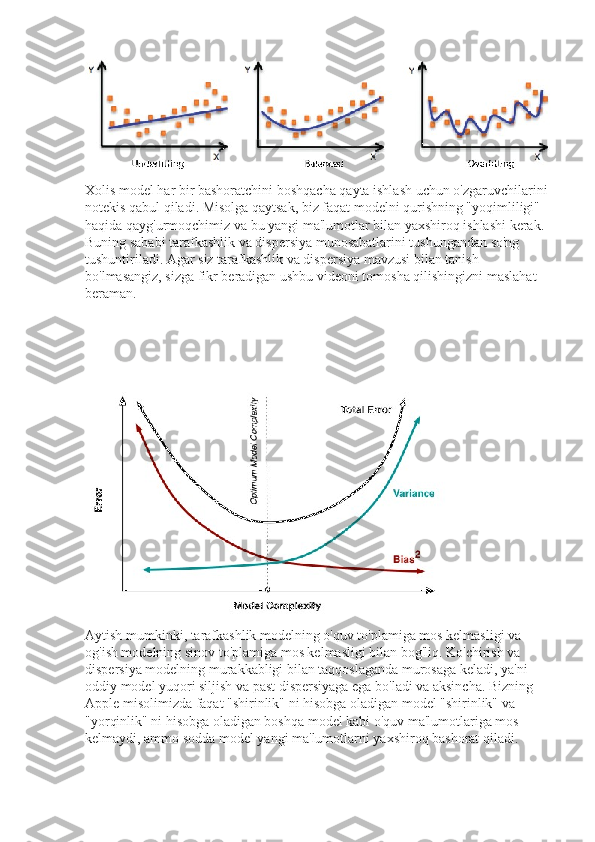

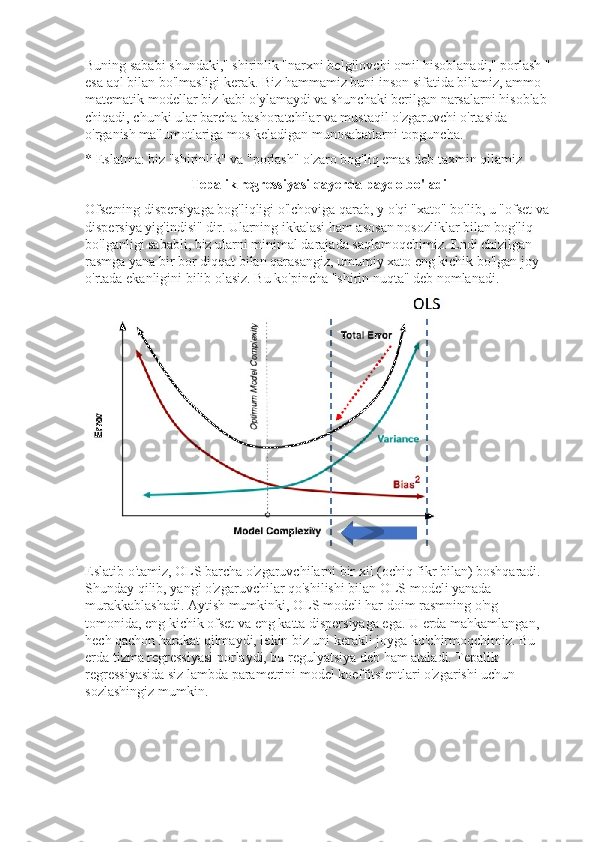

3.O'rganilayotgan funktsiyaning kirish xususiyati tasvirini aniqlang. O'rganilgan funktsiyaning aniqligi kirish ob'ekti qanday taqdim etilishiga bog'liq. Odatda, kirish ob'ekti ob'ektni tavsiflovchi bir qator xususiyatlarni o'z ichiga olgan xususiyatlar vektoriga aylantiriladi. O'lchov la'nati tufayli funktsiyalar soni juda ko'p bo'lmasligi kerak; ammo natijani aniq bashorat qilish uchun etarli ma'lumotni o'z ichiga olishi kerak. 4.O'rganilayotgan funktsiyaning tuzilishini va tegishli o'rganish algoritmini aniqlang. Masalan, muhandis qo'llab-quvvatlovchi vektorli mashinalardan yoki qaror daraxtlaridan foydalanishni tanlashi mumkin. 5.Dizaynni yakunlang. Yig'ilgan o'quv to'plamida o'quv algoritmini ishga tushiring. Ba'zi boshqariladigan o'rganish algoritmlari foydalanuvchidan ma'lum boshqaruv parametrlarini aniqlashni talab qiladi. Ushbu parametrlarni o'quv to'plamining pastki qismining ishlashini optimallashtirish (tasdiqlash to'plami deb ataladi) yoki o'zaro tekshirish orqali sozlash mumkin. 6.O'rganilgan funktsiyaning aniqligini baholang. Sozlamalar va treninglar o'rnatilgandan so'ng, natijada paydo bo'lgan funktsiyaning ishlashi o'quv to'plamidan ajratilgan test to'plamida o'lchanishi kerak. Algorit mni t anlash Nazorat ostida o'rganish algoritmlarining keng doirasi mavjud, ularning har biri o'zining kuchli va zaif tomonlariga ega. Barcha nazorat ostida o'rganish muammolarini hal qilish uchun eng mos keladigan yagona o'rganish algoritmi mavjud emas (bepul ovqatlanish teoremasiga qarang). Nazorat ostida o'qitishda e'tiborga olish kerak bo'lgan to'rtta asosiy savol mavjud: 1.Tarafk ashlik v a dispersiy a o'rt asidagi k elishuv Birinchi muammo-bu o'zaro kelishuv tarafkashlik va dispersiya. Tasavvur qiling-a, bizda bir nechta turli xil, ammo bir xil darajada yaxshi o'quv ma'lumotlari to'plamlari mavjud. O'quv algoritmi ma'lum

bir kirish uchun ofsetdir {\displaystyle x}x agar ushbu ma'lumotlar to'plamlarining har birida o'qitishda {\displaystyle x}x uchun to'g'ri natijani bashorat qilishda muntazam ravishda noto'g'ri bo'lsa. o'quv to'plamlari. O'rganilgan tasniflagichni bashorat qilish xatosi o'rganish algoritmining siljishi va dispersiyasi yig'indisi bilan bog'liq.Odatda, tarafkashlik va og'ish o'rtasida kelishuv mavjud. Ma'lumotni yaxshi ishlashi uchun past darajadagi o'rganish algoritmi "moslashuvchan" bo'lishi kerak. Ammo agar o'rganish algoritmi juda moslashuvchan bo'lsa, u har bir o'quv ma'lumotlari to'plamiga har xil mos keladi va shuning uchun yuqori dispersiyaga ega bo'ladi. Ko'pgina nazorat ostida o'qitish usullarining asosiy jihati shundaki, ular ofset va og'ish o'rtasidagi ushbu kelishuvni tartibga solishga qodir (yoki avtomatik ravishda yoki foydalanuvchi sozlashi mumkin bo'lgan ofset / rad etish parametrini taqdim etish orqali). 2.Funk t siy alarning murak k abligi v a o'quv ma'lumot larining hajmi Ikkinchi muammo - "haqiqiy" funktsiyaning murakkabligi (klassifikator yoki regressiya funktsiyasi) bo'yicha mavjud bo'lgan o'quv ma'lumotlari soni. Agar haqiqiy funktsiya sodda bo'lsa, unda yuqori xato va past dispersiyaga ega bo'lgan" egiluvchan " o'rganish algoritmi uni oz miqdordagi ma'lumotlardan o'rganishi mumkin. Ammo agar haqiqiy funktsiya juda murakkab bo'lsa (masalan, u turli xil kirish funktsiyalari o'rtasidagi murakkab o'zaro ta'sirlarni o'z ichiga olganligi va kirish maydonining turli qismlarida boshqacha harakat qilganligi sababli), u holda funktsiya faqat "moslashuvchan" past darajadagi o'rganish algoritmi bilan birgalikda katta miqdordagi o'quv ma'lumotlari bilan o'qitilishi mumkin.va yuqori dispersiya . 3. Kirish may donining o'lchami Uchinchi muammo-kirish maydonining o'lchami. Agar kirish xususiyat vektorlari katta bo'lsa, funktsiyani o'rganish qiyin bo'lishi mumkin, hatto haqiqiy funktsiya faqat ushbu xususiyatlarning oz soniga bog'liq bo'lsa ham. Buning sababi shundaki, ko'plab "qo'shimcha" o'lchovlar o'rganish algoritmini chalkashtirib yuborishi va uning yuqori dispersiyasiga olib kelishi mumkin. Shuning uchun, katta hajmdagi kirishlar odatda tasniflagichni past dispersiya va yuqori xato chegarasi

uchun sozlashni talab qiladi. Amalda, agar muhandis keraksiz funktsiyalarni kirishdan qo'lda olib tashlashi mumkin bo'lsa, bu o'rganilgan funktsiyaning aniqligini oshirishi mumkin. Bundan tashqari, ko'plab algoritmlar mavjud uchinchi muammo - kirish maydonining o'lchami. Agar kirish xususiyat vektorlari katta bo'lsa, funktsiyani o'rganish qiyin bo'lishi mumkin, hatto haqiqiy funktsiya faqat ushbu xususiyatlarning oz soniga bog'liq bo'lsa ham. Buning sababi shundaki, ko'plab "qo'shimcha" o'lchovlar o'rganish algoritmini chalkashtirib yuborishi va uning yuqori dispersiyasiga olib kelishi mumkin. 4. Chiqish qiy mat larida shov qin qayta o'qitish, ma'lumotlarning juda ehtiyotkorlik bilan o'rnatilishi quyidagilarga olib keladi agar kerakli chiqish qiymatlari ko'pincha noto'g'ri bo'lsa (inson xatosi yoki sensor xatolari tufayli), unda o'rganish algoritmi o'quv misollariga to'liq mos keladigan funktsiyani topishga urinmasligi kerak. Agar talab qilinadigan chiqish qiymatlari ko'pincha noto'g'ri bo'lsa (inson xatosi yoki sensor xatolari tufayli), unda o'rganish algoritmi funktsiyani topishga urinmasligi kerak maqsadli o'zgaruvchilar, teskari savol-kerakli chiqish qiymatlaridagi shovqin darajasi (mos yozuvlar . Agar siz o'rganmoqchi bo'lgan xususiyat sizning o'rganish modelingiz uchun juda murakkab bo'lsa, o'lchov xatolari (stoxastik shovqin) bo'lmasa ham, siz qayta o'rganishingiz mumkin. Bunday vaziyatda maqsadli funktsiyaning modellashtirilmaydigan qismi sizning o'quv ma'lumotlaringizni "buzadi" - bu hodisa deyiladi . Agar siz o'rganmoqchi bo'lgan xususiyat sizning o'rganish modelingiz uchun juda murakkab bo'lsa, o'lchov xatolari (stoxastik shovqin) bo'lmasa ham, siz qayta o'rganishingiz mumkin.