Sun`iy neyron turlari asosida jarayon va tizimlarnimodellarlashtirish LAB

![Sun`iy neyron turlari asosida jarayon va tizimlarnimodellarlashtirish

Neyron tarmoqlari misollarni qayta ishlash orqali o'rganadi (yoki o'qitiladi), ularning

har biri ma'lum bo'lgan "kirish" va "natija" ni o'z ichiga oladi, bu ikkalasi o'rtasida

aniqlik tarkibidagi ma'lumotlar assotsiatsiyasini shakllantiradi. Nerv tarmog'ini

keltirilgan misoldan o'rgatish odatda tarmoqning qayta ishlangan chiqishi (ko'pincha

bashorat qilish) va maqsadli chiqish o'rtasidagi farqni aniqlash orqali amalga oshiriladi.

Bu xato. Keyin tarmoq o'z qoidalariga binoan va ushbu xatolik qiymatidan foydalangan

holda o'z vaznli assotsiatsiyalarini sozlaydi. Ketma-ket tuzatishlar neyron tarmoqni

maqsadli chiqishga tobora ko'proq o'xshash ishlab chiqarishni keltirib chiqaradi. Ushbu

tuzatishlarning etarli sonidan so'ng ma'lum mezonlarga asoslanib, mashg'ulot tugatilishi

mumkin. Bu sifatida tanilgan nazorat ostida o'rganish .

Bunday tizimlar, misollarni ko'rib chiqish orqali vazifalarni bajarishni "o'rganadilar",

odatda vazifalarga xos qoidalar bilan dasturlashtirilmasdan. Masalan, ichida tasvirni

aniqlash , ular qo'lda qilingan misollarni tahlil qilish orqali mushuklarni o'z ichiga olgan

rasmlarni aniqlashni o'rganishlari mumkin belgilangan "mushuk" yoki "mushuk yo'q"

sifatida va boshqa rasmlarda mushuklarni aniqlash uchun natijalardan foydalanish. Ular

buni mushuklar haqida oldindan bilmasdan qilishadi, masalan, ularning mo'ynasi,

dumlari, mo'ylovi va mushukka o'xshash yuzlari. Buning o'rniga, ular avtomatik

ravishda ishlov beradigan misollardan aniqlovchi xususiyatlarni yaratadilar.

ANNlarning tarkibiy qismlari

Neyronlar

ANNlar tarkib topgan sun'iy neyronlar kontseptual ravishda biologik olingan neyronlar .

Har bir sun'iy neyronning kirishlari mavjud va ular bir nechta boshqa neyronlarga

yuborilishi mumkin bo'lgan bitta ishlab chiqarishni ishlab chiqaradi. Kirish rasmlar yoki

hujjatlar kabi tashqi ma'lumotlar namunasining xususiyat qiymatlari yoki boshqa

neyronlarning chiqishi bo'lishi mumkin. Final natijalari chiqish neyronlari asab tarmog'i

vazifani bajaradi, masalan, rasmdagi ob'ektni tanib olish.

Neyronning chiqishini topish uchun avval biz tomonidan tortilgan barcha kirishlarning

tortilgan yig'indisini olamiz og'irliklar ning ulanishlar kirishlardan neyrongacha. Biz

qo'shamiz tarafkashlik ushbu summa uchun muddat. Ushbu tortilgan yig'indiga ba'zan

deyiladi faollashtirish . Ushbu tortilgan yig'indidan keyin (odatda chiziqli

bo'lmagan) faollashtirish funktsiyasi mahsulotni ishlab chiqarish. Dastlabki yozuvlar

tashqi ma'lumotlar, masalan, rasm va hujjatlar. Rasmdagi ob'ektni tanib olish kabi

yakuniy natijalar vazifani bajaradi. [40]

Aloqalar va og'irliklar

Tarmoq ulanishlardan iborat bo'lib, har bir ulanish bitta neyronning chiqishini boshqa

neyronga kirish sifatida ta'minlaydi. Har bir ulanishga uning nisbiy ahamiyatini

anglatadigan og'irlik beriladi. [38]

Berilgan neyron bir nechta kirish va chiqish aloqalariga

ega bo'lishi mumkin. [41]](/data/documents/4d3123f0-6197-4ada-90ad-731b15855e20/page_3.png)

![Ko'paytirish funktsiyasi

The tarqalish funktsiyasi oldingi neyronlarning chiqishi va ularning birikmalaridan

neyronga kirishni og'irlikdagi summa sifatida hisoblab chiqadi.

[38]

A tarafkashlik targ'ibot natijasiga muddat qo'shilishi mumkin. [42]

Tashkilot

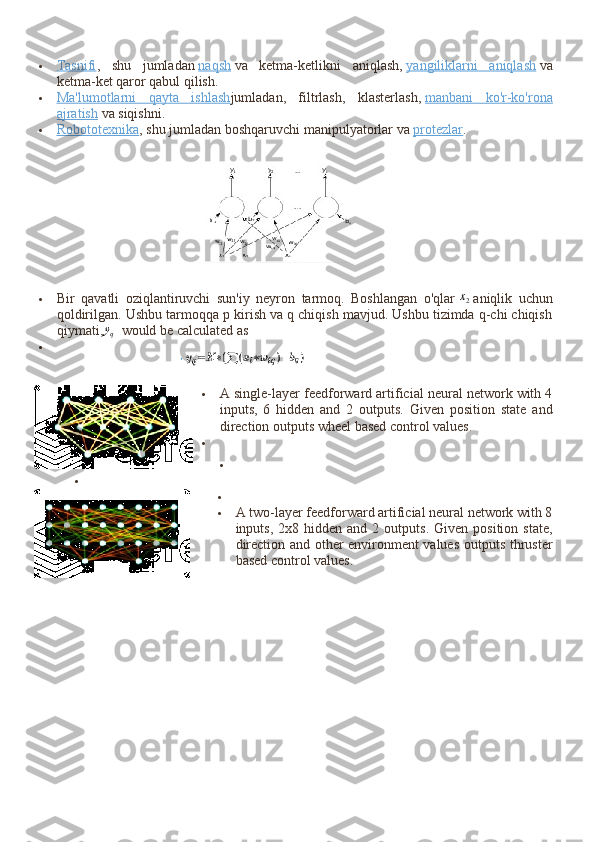

Neyronlar odatda bir nechta qatlamlarga bo'linadi, ayniqsa chuqur o'rganish . Bir qatlam

neyronlari faqat oldingi va darhol keyingi qatlamlarning neyronlari bilan bog'lanadi.

Tashqi ma'lumotlarni qabul qiladigan qatlam bu kirish qatlami . Yakuniy natija

beradigan qatlam bu chiqish qatlami . Ularning orasidagi nol yoki undan ko'p yashirin

qatlamlar . Bir qavatli va qatlamsiz tarmoqlardan ham foydalaniladi. Ikki qatlam

o'rtasida bir nechta ulanish naqshlari mumkin. Ular bo'lishi mumkin to'liq ulangan , bitta

qatlamdagi har bir neyron keyingi qatlamdagi har bir neyron bilan bog'langan holda.

Ular bo'lishi mumkin hovuzlash , bu erda bir qatlamdagi neyronlar guruhi keyingi

qatlamdagi bitta neyronga ulanadi va shu bilan ushbu qatlamdagi neyronlarning sonini

kamaytiradi. [43]

Faqat shu kabi birikmalarga ega neyronlar a ni hosil qiladi yo'naltirilgan

asiklik grafik va sifatida tanilgan feedforward tarmoqlari . [44]

Shu bilan bir qatorda, bir

xil yoki oldingi qatlamlarda neyronlar orasidagi bog'lanishni ta'minlaydigan tarmoqlar

sifatida tanilgan takroriy tarmoqlar . [45]

Giperparametr

Asosiy maqola: Giperparametr (mashinada o'rganish)

Giperparametr doimiydir parametr uning qiymati o'quv jarayoni boshlanishidan oldin

belgilanadi. Parametrlarning qiymatlari o'rganish orqali olinadi. Giperparametrlarga

misollar kiradi o'rganish darajasi , yashirin qatlamlar soni va partiyaning hajmi. [46]

Ba'zi

giperparametrlarning qiymatlari boshqa giperparametrlarga bog'liq bo'lishi mumkin.

Masalan, ba'zi qatlamlarning kattaligi qatlamlarning umumiy soniga bog'liq bo'lishi

mumkin.

Shuningdek qarang: Matematik optimallashtirish , Baholash nazariyasi va Mashinada

o'qitish

O'rganish - bu kuzatuvlarning namunalarini ko'rib chiqish orqali vazifani yaxshiroq

bajarish uchun tarmoqni moslashtirish. O'rganish natijaning aniqligini oshirish uchun

tarmoqning og'irliklarini (va ixtiyoriy chegaralarini) sozlashni o'z ichiga oladi. Bu

kuzatilgan xatolarni minimallashtirish orqali amalga oshiriladi. Qo'shimcha

kuzatuvlarni o'rganishda xatolik darajasi foydali ravishda kamaytirilmasa, o'rganish

tugallanadi. O'rgandan keyin ham xato darajasi odatda 0 ga etmaydi. Agar o'rgangandan

so'ng xato darajasi juda yuqori bo'lsa, tarmoq odatda qayta ishlab chiqilishi kerak.

Amalda bu a ni aniqlash orqali amalga oshiriladi xarajat funktsiyasi bu o'rganish paytida

vaqti-vaqti bilan baholanadi. Uning ishlab chiqarish hajmi pasayishda davom etar ekan,

o'rganish davom etadi. Xarajat tez-tez a sifatida belgilanadi statistik uning qiymati faqat

taxminiy bo'lishi mumkin. Chiqishlar aslida raqamlar, shuning uchun xato kam bo'lsa,

chiqish (deyarli mushuk) va to'g'ri javob (mushuk) o'rtasidagi farq juda oz. Kuzatishlar

bo'yicha farqlarning umumiy miqdorini kamaytirishga o'rganish. [38]

Ko'pgina o'quv

modellari to'g'ridan-to'g'ri dastur sifatida qaralishi mumkin optimallashtirish nazariya

va statistik baho .](/data/documents/4d3123f0-6197-4ada-90ad-731b15855e20/page_4.png)

![O'quv darajasi

O'quv darajasi model har bir kuzatuvdagi xatolarni to'g'rilash uchun zarur bo'lgan

tuzatish bosqichlarining hajmini belgilaydi. O'qishning yuqori darajasi mashg'ulot

vaqtini qisqartiradi, ammo yakuniy aniqligi pastroq, o'qish darajasi pastroq bo'lsa,

ko'proq aniqlik olish imkoniyati mavjud. Kabi optimallashtirishlar Quickprop birinchi

navbatda xatolarni minimallashtirishni tezlashtirishga qaratilgan bo'lib, boshqa

yaxshilanishlar asosan ishonchliligini oshirishga harakat qiladi. Tarmoq ichidagi

o'zgaruvchan ulanish og'irliklari kabi tebranishdan saqlanish va konvergentsiya tezligini

oshirish uchun yaxshilanishlar adaptiv ta'lim darajasi tegishli ravishda ko'payadi yoki

kamayadi. [47]

Impuls momenti tushunchasi gradient va oldingi o'zgarish o'rtasidagi

muvozanatni og'irlik sozlamalari avvalgi o'zgarishga ma'lum darajada bog'liq bo'lishi

uchun tortish imkonini beradi. 0 ga yaqin momentum gradiyentni ta'kidlaydi, 1 ga yaqin

qiymat oxirgi o'zgarishni ta'kidlaydi.

Xarajat funktsiyasi

Xarajat funktsiyasini aniqlash mumkin bo'lsa-da maxsus , tez-tez tanlov funktsiyaning

kerakli xususiyatlari bilan belgilanadi (masalan qavariqlik ) yoki u modeldan kelib

chiqqanligi sababli (masalan, ehtimollik modelida modelning) orqa ehtimollik teskari

xarajat sifatida ishlatilishi mumkin).

Orqaga targ'ib qilish

Asosiy maqola: Orqaga targ'ib qilish

Backpropagation - bu o'rganish paytida topilgan har bir xato o'rnini qoplash uchun

ulanish og'irliklarini sozlash usuli. Xato miqdori ulanishlar orasida samarali ravishda

bo'linadi. Texnik jihatdan, backprop hisoblaydi gradient (lotin) ning xarajat

funktsiyasi og'irliklarga nisbatan berilgan holat bilan bog'liq. Og'irlikni yangilash orqali

amalga oshirilishi mumkin stoxastik gradient tushish yoki boshqa usullar,

masalan Ekstremal o'quv mashinalari , [48]

"Yoqilg'i yo'q" tarmoqlari, [49]

orqaga

qaytmasdan mashq qilish, [50]

"vaznsiz" tarmoqlar, [51] [52]

va konnektistik bo'lmagan

neyron tarmoqlar .

Paradigmalarni o'rganish

Uchta asosiy o'rganish paradigmalari nazorat ostida o'rganish , nazoratsiz

o'rganish va mustahkamlashni o'rganish . Ularning har biri ma'lum bir o'quv vazifasiga

mos keladi

Nazorat ostida o'rganish

Nazorat ostida o'rganish juftlashtirilgan kirish va kerakli natijalar to'plamidan

foydalanadi. O'quv vazifasi har bir kirish uchun kerakli natijani ishlab chiqarishdir.

Bunday holda xarajat funktsiyasi noto'g'ri ajratmalarni yo'q qilish bilan bog'liq.

[53]

Odatda ishlatiladigan narx bu o'rtacha kvadratik xato , bu tarmoq chiqishi va kerakli

chiqish o'rtasidagi o'rtacha kvadratik xatoni minimallashtirishga harakat qiladi. Nazorat

ostida o'rganish uchun mos vazifalar naqshni aniqlash (shuningdek, tasnif deb ham

ataladi) va regressiya (funktsiyani yaqinlashtirish deb ham ataladi). Nazorat ostidagi

ta'lim ketma-ket ma'lumotlarga ham tegishli (masalan, qo'lda yozish, nutq va imo-

ishoralarni aniqlash ). Buni "o'qituvchi" bilan o'rganish, shu vaqtgacha olingan echimlar](/data/documents/4d3123f0-6197-4ada-90ad-731b15855e20/page_5.png)

![sifati to'g'risida uzluksiz teskari aloqani ta'minlaydigan funktsiya shaklida tasavvur

qilish mumkin.

Nazorat qilinmagan o'rganish

Yilda nazoratsiz o'rganish , kirish ma'lumotlari xarajat funktsiyasi, ma'lumotlarning ba'zi

funktsiyalari bilan birga beriladi va tarmoq chiqishi. Xarajat funktsiyasi vazifaga

(model domeniga) va har qanday narsaga bog'liq apriori taxminlar (modelning yashirin

xususiyatlari, uning parametrlari va kuzatilgan o'zgaruvchilar). Arzimas misol sifatida

modelni ko'rib chiqing qayerda doimiy va xarajatdir . Ushbu xarajatlarni

minimallashtirish qiymati hosil qiladi bu ma'lumotlarning o'rtacha qiymatiga teng.

Xarajat funktsiyasi ancha murakkab bo'lishi mumkin. Uning shakli dasturga bog'liq:

masalan, ichida siqilish bilan bog'liq bo'lishi mumkin o'zaro ma'lumot o'rtasida

va , statistik modellashtirishda esa, bilan bog'liq bo'lishi mumkin orqa

ehtimollik ma'lumotlar berilgan model (ushbu ikkala misolda ham ushbu miqdorlar

minimallashtirilgan emas, balki maksimal darajaga ko'tarilishini unutmang). Nazorat

qilinmagan o'rganish paradigmasiga kiradigan vazifalar umuman olganda taxmin

qilish muammolar; dasturlarga kiradi klasterlash , taxminiy statistik

taqsimotlar , siqilish va filtrlash .

Kuchaytirishni o'rganish

Asosiy maqola: Kuchaytirishni o'rganish

Shuningdek qarang: Stoxastik nazorat

Video o'yinlarni o'ynash kabi dasturlarda aktyor bir nechta harakatlarni amalga oshiradi,

har biridan keyin atrof-muhitdan umuman kutilmagan javob oladi. Maqsad - o'yinni

yutish, ya'ni eng ijobiy (eng kam xarajatli) javoblarni yaratish. Yilda mustahkamlashni

o'rganish , maqsadi uzoq muddatli (kutilayotgan kümülatif) xarajatlarni

minimallashtiradigan harakatlarni amalga oshirish uchun tarmoqni og'irlashtirish

(siyosat ishlab chiqish). Vaqtning har bir nuqtasida agent harakatni amalga oshiradi va

atrof-muhit kuzatuv va bir zumda xarajatlarni keltirib chiqaradi, ba'zi (odatda

noma'lum) qoidalarga muvofiq. Qoidalar va uzoq muddatli xarajatlarni odatda faqat

taxmin qilish mumkin. Har qanday vaqtda agent o'z xarajatlarini qoplash uchun yangi

harakatlarni kashf etish yoki tezroq davom etish uchun oldindan o'rganishdan

foydalanish to'g'risida qaror qabul qiladi.

Rasmiy ravishda atrof muhit modellashtirilgan Markovning qaror qabul qilish

jarayoni (MDP) davlatlar bilan va harakatlar . Shtat o'tishlari ma'lum

bo'lmaganligi sababli, ehtimollik taqsimotidan foydalaniladi: xarajatlarni oniy

taqsimlash , kuzatuv taqsimoti va o'tish taqsimoti , siyosat esa kuzatuvlar

asosida amallar bo'yicha shartli taqsimlash sifatida aniqlanadi. Birgalikda ikkalasi a ni

belgilaydi Markov zanjiri (MC). Maqsad eng arzon narxlardagi MCni topishdir.

ANNlar bunday dasturlarda o'quv komponenti bo'lib xizmat qiladi. [54] [55]

Dinamik

dasturlash ANNlar bilan birgalikda (neyrodinamik dasturlash) [56]

kabi muammolarga](/data/documents/4d3123f0-6197-4ada-90ad-731b15855e20/page_6.png)

![nisbatan qo'llanilgan transport vositasini yo'naltirish , [57]

video O'yinlar, tabiiy resurslarni

boshqarish [58]

[59]

va Dori [60]

ANN-larning aniqligi yo'qotishlarini yumshatish qobiliyati

tufayli, diskretizatsiya panjarasi zichligini kamaytirganda ham, boshqaruv masalalari

echimini son jihatdan yaqinlashtirish uchun. Armaturani o'rganish paradigmasiga

kiradigan vazifalar nazorat muammolari, o'yinlar va boshqa ketma-ket qaror qabul qilish

vazifalari.

O'z-o'zini o'rganish

Nerv tarmoqlarida o'z-o'zini o'rganish 1982 yilda "Crossbar Adaptive Array" (CAA)

nomli o'z-o'zini o'rganishga qodir bo'lgan neyron tarmoq bilan birga joriy qilingan.

[61]

Bu faqat bitta kirish, vaziyat s va faqat bitta chiqish, harakat (yoki xatti-harakatlar)

ga ega bo'lgan tizim. Unda tashqi maslahat va atrof-muhitning tashqi mustahkamlovchi

ma'lumotlari mavjud emas. CAA shpal shaklida har ikkala qarorni va duch kelgan

vaziyatlarga nisbatan his-tuyg'ularni (hissiyotlarni) hisoblab chiqadi. Tizim idrok va

hissiyotlarning o'zaro ta'siridan kelib chiqadi. [62]

Berilgan xotira matritsasi W = || w (a, s)

||, har bir iteratsiyada o'zaro faoliyat o'qitish algoritmi quyidagi hisoblashni amalga

oshiradi:

Vaziyatda s harakatni bajaring a; Oqibatlarga olib keladigan vaziyatni oling; V (lar)

holatida bo'lish hissiyotini hisoblash; W '(a, s) = w (a, s) + v (s ’) xoch xotirasini

yangilang.

Backpropagated qiymati (ikkilamchi mustahkamlash) oqibat vaziyatiga nisbatan

hissiyotdir. CAA ikki muhitda mavjud bo'lib, ulardan biri o'zini tutadigan xulq-atvori

muhiti, ikkinchisi genetik muhit bo'lib, undan dastlab va faqat bir marta xulq-atvor

muhitida yuzaga keladigan vaziyatlarga duch keladigan dastlabki hissiyotlarni oladi.

Genetika muhitidan genom vektorini (turlar vektori) olgan CAA, istalgan va kiruvchi

vaziyatlarni o'z ichiga olgan xulq-atvor muhitida maqsadga intilishni o'rganadi. [63]

Boshqalar

A Bayesiyalik ramka, tannarxni minimallashtirish uchun ruxsat berilgan modellar

to'plami bo'yicha taqsimlash tanlanadi. Evolyutsion usullar , [64]

gen ekspressionini

dasturlash , [65]

simulyatsiya qilingan tavlanish , [66]

kutish-maksimallashtirish , parametrik

bo'lmagan usullar va zarrachalar to'dasini optimallashtirish [67]

boshqa o'quv algoritmlari.

Konvergent rekursiya - bu o'rganish algoritmi serebellar modeli artikulyatsiyasi

tekshiruvi (CMAC) neyron tarmoqlari. [68] [69]

Rejimlar

O'qishning ikkita usuli mavjud: stoxastik va ommaviy. Stoxastik o'rganishda har bir

ma'lumot og'irlik sozlamasini yaratadi. Partiyada o'qitish og'irliklari to'plamdagi xatolar

to'planib, ma'lumotlar to'plami asosida o'rnatiladi. Stoxastik ta'lim jarayonga bitta

shovqin nuqtasidan hisoblangan lokal gradyan yordamida "shovqin" kiritadi; bu

tarmoqning mahalliy minimalarga yopishib qolish imkoniyatini pasaytiradi. Biroq,

ommaviy o'rganish odatda mahalliy minimal darajaga tezroq va barqaror tushishni

ta'minlaydi, chunki har bir yangilanish partiyaning o'rtacha xatosi yo'nalishida amalga

oshiriladi. Umumiy kelishuv - bu "mini-partiyalar", har bir partiyadagi namunalari

bo'lgan kichik partiyalar, butun ma'lumotlar to'plamidan stoxastik ravishda tanlangan.

Funktsiyani yaqinlashtirish , yoki regressiya tahlili , shu jumladan vaqt qatorini bashorat

qilish , fitnessni taxmin qilish va modellashtirish.](/data/documents/4d3123f0-6197-4ada-90ad-731b15855e20/page_7.png)

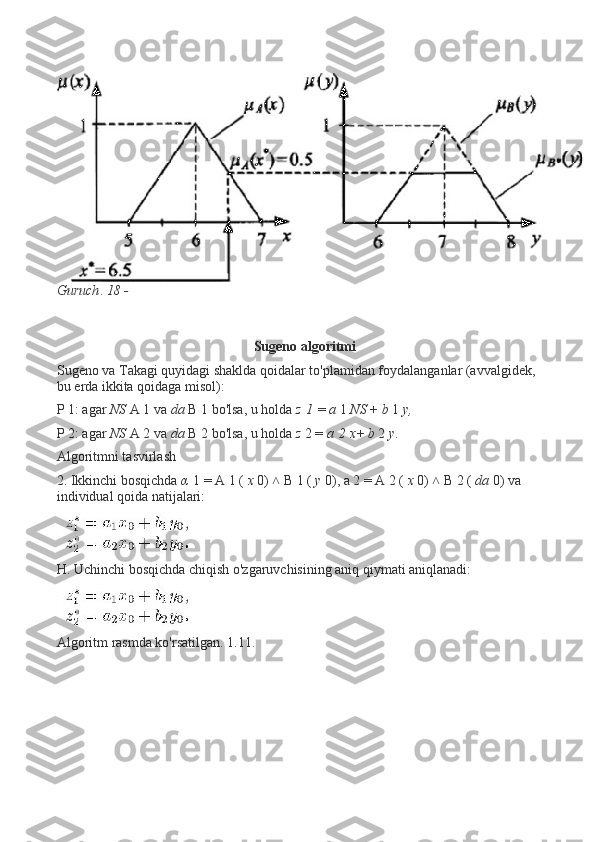

![SUGENO algoritmi asosida noqatiy xulosa chiqarish

Loyqa xulosa chiqarish jarayonining tipik tuzilishi shaklda ko'rsatilgan. 17.

Guruch, 17

Avvalo, loyqa ishlab chiqarishlar uchun cheklangan qoidalar to'plami bo'lgan qoidalar

bazasini shakllantirish kerak. Qoidalar bazasini shakllantirish kirish va chiqish

lingvistik o'zgaruvchilarni, shuningdek, qoidalarning o'zini aniqlashni o'z ichiga oladi.

Kirish lingvistik o zgaruvchilari qoida subshartlarida qo llaniladigan lingvistik ʻ ʻ

o zgaruvchilardir. Chiqish o'zgaruvchilari - Qoidalar kichik bandlarida ishlatiladigan

ʻ

o'zgaruvchilar. Lingvistik o zgaruvchilarning ta rifi o zgaruvchilarning asosiy atama

ʻ ʼ ʻ

to plamlari va atamalar to plamining a zolik funksiyalarini belgilashni anglatadi.

ʻ ʻ ʼ

Qoidalar 2.4-bo'limda muhokama qilinganidek shakllantiriladi. Har bir qoidaga

intervaldan qiymat oladigan vazn belgilanishi mumkin. Og'irlik bo'lmasa, vazn nolga

teng deb hisoblanishi mumkin.

Loyqa xulosalar tizimining kiritilishida lingvistik o'zgaruvchilarning aniq

qiymatlarining x * = [*, *, * 2, »? **,] vektori olinadi. o'zgaruvchilar. Buning uchun

lingvistik o'zgaruvchining har bir atamasining vazifalari ma'lum bo'lishi kerak.

Fuzzifikatsiya quyidagi tarzda amalga oshiriladi. Har bir kirish lingvistik o'zgaruvchisi

q uchun uning son qiymati ma'lum bo'lsin NS*. q o'zgaruvchisi paydo bo'ladigan har bir

subshart bayonoti, masalan, "p. u yerda qayerdan os ( -ma'lum a'zolik funksiyasi bilan

atama [la). Ma'nosi NS* argument sifatida ishlatiladi // (l), natijada = d (x *). Bunday

holda, modifikatorlardan foydalanish mumkin. Shunday qilib, loyqa xulosalar

tizimining barcha pastki shartlarining haqiqat qiymatlari hisoblanadi. Subshartlardagi

gaplar raqamlar bilan almashtiriladi. Loyqalanish blokining chiqishida vektor m = hosil

bo'ladi, bu chiqish blokining kirish qismidir.

Loyqa xulosa bloki kirishda barcha pastki shartlarning haqiqat darajasining vektorini

oladi T va chiqish qiymatining hosil bo'lgan a'zolik funksiyasini hisoblab chiqadi

(chiqarish tizimi bir nechta chiqishlarga ega bo'lishi mumkin, keyin biz chiqish vektori

haqida gapiramiz). Olingan a'zolik funktsiyasini hisoblash quyidagi protseduralarni o'z

ichiga oladi (protseduralar nomlari IEC 1131 - Programlanadigan kontrollerlar

kontrollerlari uchun dasturlash tillarining xalqaro standartiga muvofiq qavs ichida

ko'rsatilgan. 7-qism - Loyqa boshqaruv dasturlash):

- shartlarning haqiqat darajasini hisoblash (Aggregatsiya - yig'ish);

- xulosalar a'zoligining faollashtirilgan funksiyalarini aniqlash (Activftion -

faollashtirish);

- chiqish lingvistik o'zgaruvchilarning natijaviy a'zolik funktsiyalarini aniqlash

(Akkumulyatsiya).](/data/documents/4d3123f0-6197-4ada-90ad-731b15855e20/page_9.png)

O’ZBEKISTON RESPUBLIKASI OLIY VA O’RTA MAXSUS TA’LIM VAZIRLIGI SAMARQAND DAVLAT UNIVERSITETI RAQAMLI TEXNOLOGIYALAR FAKULTETI INFORMATIKA O’QITISH METODIKASI YO’NALISHI LABORATORIYA ISHI MAVZU: Sun`iy neyron turlari asosida jarayon va tizimlarnimodellarlashtirish Samarqand-2021 MAVZU: Sun`iy neyron turlari asosida jarayon va tizimlarni modellarlashtirish

1. ANNlarning tarkibiy qismlari 2. SUGENO algoritmi asosida noqatiy xulosa chiqarish 3. MAMDAE algoritmi asosida noqatiy xulosa chiqarish mexanizmini shakllantirish

Sun`iy neyron turlari asosida jarayon va tizimlarnimodellarlashtirish Neyron tarmoqlari misollarni qayta ishlash orqali o'rganadi (yoki o'qitiladi), ularning har biri ma'lum bo'lgan "kirish" va "natija" ni o'z ichiga oladi, bu ikkalasi o'rtasida aniqlik tarkibidagi ma'lumotlar assotsiatsiyasini shakllantiradi. Nerv tarmog'ini keltirilgan misoldan o'rgatish odatda tarmoqning qayta ishlangan chiqishi (ko'pincha bashorat qilish) va maqsadli chiqish o'rtasidagi farqni aniqlash orqali amalga oshiriladi. Bu xato. Keyin tarmoq o'z qoidalariga binoan va ushbu xatolik qiymatidan foydalangan holda o'z vaznli assotsiatsiyalarini sozlaydi. Ketma-ket tuzatishlar neyron tarmoqni maqsadli chiqishga tobora ko'proq o'xshash ishlab chiqarishni keltirib chiqaradi. Ushbu tuzatishlarning etarli sonidan so'ng ma'lum mezonlarga asoslanib, mashg'ulot tugatilishi mumkin. Bu sifatida tanilgan nazorat ostida o'rganish . Bunday tizimlar, misollarni ko'rib chiqish orqali vazifalarni bajarishni "o'rganadilar", odatda vazifalarga xos qoidalar bilan dasturlashtirilmasdan. Masalan, ichida tasvirni aniqlash , ular qo'lda qilingan misollarni tahlil qilish orqali mushuklarni o'z ichiga olgan rasmlarni aniqlashni o'rganishlari mumkin belgilangan "mushuk" yoki "mushuk yo'q" sifatida va boshqa rasmlarda mushuklarni aniqlash uchun natijalardan foydalanish. Ular buni mushuklar haqida oldindan bilmasdan qilishadi, masalan, ularning mo'ynasi, dumlari, mo'ylovi va mushukka o'xshash yuzlari. Buning o'rniga, ular avtomatik ravishda ishlov beradigan misollardan aniqlovchi xususiyatlarni yaratadilar. ANNlarning tarkibiy qismlari Neyronlar ANNlar tarkib topgan sun'iy neyronlar kontseptual ravishda biologik olingan neyronlar . Har bir sun'iy neyronning kirishlari mavjud va ular bir nechta boshqa neyronlarga yuborilishi mumkin bo'lgan bitta ishlab chiqarishni ishlab chiqaradi. Kirish rasmlar yoki hujjatlar kabi tashqi ma'lumotlar namunasining xususiyat qiymatlari yoki boshqa neyronlarning chiqishi bo'lishi mumkin. Final natijalari chiqish neyronlari asab tarmog'i vazifani bajaradi, masalan, rasmdagi ob'ektni tanib olish. Neyronning chiqishini topish uchun avval biz tomonidan tortilgan barcha kirishlarning tortilgan yig'indisini olamiz og'irliklar ning ulanishlar kirishlardan neyrongacha. Biz qo'shamiz tarafkashlik ushbu summa uchun muddat. Ushbu tortilgan yig'indiga ba'zan deyiladi faollashtirish . Ushbu tortilgan yig'indidan keyin (odatda chiziqli bo'lmagan) faollashtirish funktsiyasi mahsulotni ishlab chiqarish. Dastlabki yozuvlar tashqi ma'lumotlar, masalan, rasm va hujjatlar. Rasmdagi ob'ektni tanib olish kabi yakuniy natijalar vazifani bajaradi. [40] Aloqalar va og'irliklar Tarmoq ulanishlardan iborat bo'lib, har bir ulanish bitta neyronning chiqishini boshqa neyronga kirish sifatida ta'minlaydi. Har bir ulanishga uning nisbiy ahamiyatini anglatadigan og'irlik beriladi. [38] Berilgan neyron bir nechta kirish va chiqish aloqalariga ega bo'lishi mumkin. [41]

Ko'paytirish funktsiyasi The tarqalish funktsiyasi oldingi neyronlarning chiqishi va ularning birikmalaridan neyronga kirishni og'irlikdagi summa sifatida hisoblab chiqadi. [38] A tarafkashlik targ'ibot natijasiga muddat qo'shilishi mumkin. [42] Tashkilot Neyronlar odatda bir nechta qatlamlarga bo'linadi, ayniqsa chuqur o'rganish . Bir qatlam neyronlari faqat oldingi va darhol keyingi qatlamlarning neyronlari bilan bog'lanadi. Tashqi ma'lumotlarni qabul qiladigan qatlam bu kirish qatlami . Yakuniy natija beradigan qatlam bu chiqish qatlami . Ularning orasidagi nol yoki undan ko'p yashirin qatlamlar . Bir qavatli va qatlamsiz tarmoqlardan ham foydalaniladi. Ikki qatlam o'rtasida bir nechta ulanish naqshlari mumkin. Ular bo'lishi mumkin to'liq ulangan , bitta qatlamdagi har bir neyron keyingi qatlamdagi har bir neyron bilan bog'langan holda. Ular bo'lishi mumkin hovuzlash , bu erda bir qatlamdagi neyronlar guruhi keyingi qatlamdagi bitta neyronga ulanadi va shu bilan ushbu qatlamdagi neyronlarning sonini kamaytiradi. [43] Faqat shu kabi birikmalarga ega neyronlar a ni hosil qiladi yo'naltirilgan asiklik grafik va sifatida tanilgan feedforward tarmoqlari . [44] Shu bilan bir qatorda, bir xil yoki oldingi qatlamlarda neyronlar orasidagi bog'lanishni ta'minlaydigan tarmoqlar sifatida tanilgan takroriy tarmoqlar . [45] Giperparametr Asosiy maqola: Giperparametr (mashinada o'rganish) Giperparametr doimiydir parametr uning qiymati o'quv jarayoni boshlanishidan oldin belgilanadi. Parametrlarning qiymatlari o'rganish orqali olinadi. Giperparametrlarga misollar kiradi o'rganish darajasi , yashirin qatlamlar soni va partiyaning hajmi. [46] Ba'zi giperparametrlarning qiymatlari boshqa giperparametrlarga bog'liq bo'lishi mumkin. Masalan, ba'zi qatlamlarning kattaligi qatlamlarning umumiy soniga bog'liq bo'lishi mumkin. Shuningdek qarang: Matematik optimallashtirish , Baholash nazariyasi va Mashinada o'qitish O'rganish - bu kuzatuvlarning namunalarini ko'rib chiqish orqali vazifani yaxshiroq bajarish uchun tarmoqni moslashtirish. O'rganish natijaning aniqligini oshirish uchun tarmoqning og'irliklarini (va ixtiyoriy chegaralarini) sozlashni o'z ichiga oladi. Bu kuzatilgan xatolarni minimallashtirish orqali amalga oshiriladi. Qo'shimcha kuzatuvlarni o'rganishda xatolik darajasi foydali ravishda kamaytirilmasa, o'rganish tugallanadi. O'rgandan keyin ham xato darajasi odatda 0 ga etmaydi. Agar o'rgangandan so'ng xato darajasi juda yuqori bo'lsa, tarmoq odatda qayta ishlab chiqilishi kerak. Amalda bu a ni aniqlash orqali amalga oshiriladi xarajat funktsiyasi bu o'rganish paytida vaqti-vaqti bilan baholanadi. Uning ishlab chiqarish hajmi pasayishda davom etar ekan, o'rganish davom etadi. Xarajat tez-tez a sifatida belgilanadi statistik uning qiymati faqat taxminiy bo'lishi mumkin. Chiqishlar aslida raqamlar, shuning uchun xato kam bo'lsa, chiqish (deyarli mushuk) va to'g'ri javob (mushuk) o'rtasidagi farq juda oz. Kuzatishlar bo'yicha farqlarning umumiy miqdorini kamaytirishga o'rganish. [38] Ko'pgina o'quv modellari to'g'ridan-to'g'ri dastur sifatida qaralishi mumkin optimallashtirish nazariya va statistik baho .

O'quv darajasi O'quv darajasi model har bir kuzatuvdagi xatolarni to'g'rilash uchun zarur bo'lgan tuzatish bosqichlarining hajmini belgilaydi. O'qishning yuqori darajasi mashg'ulot vaqtini qisqartiradi, ammo yakuniy aniqligi pastroq, o'qish darajasi pastroq bo'lsa, ko'proq aniqlik olish imkoniyati mavjud. Kabi optimallashtirishlar Quickprop birinchi navbatda xatolarni minimallashtirishni tezlashtirishga qaratilgan bo'lib, boshqa yaxshilanishlar asosan ishonchliligini oshirishga harakat qiladi. Tarmoq ichidagi o'zgaruvchan ulanish og'irliklari kabi tebranishdan saqlanish va konvergentsiya tezligini oshirish uchun yaxshilanishlar adaptiv ta'lim darajasi tegishli ravishda ko'payadi yoki kamayadi. [47] Impuls momenti tushunchasi gradient va oldingi o'zgarish o'rtasidagi muvozanatni og'irlik sozlamalari avvalgi o'zgarishga ma'lum darajada bog'liq bo'lishi uchun tortish imkonini beradi. 0 ga yaqin momentum gradiyentni ta'kidlaydi, 1 ga yaqin qiymat oxirgi o'zgarishni ta'kidlaydi. Xarajat funktsiyasi Xarajat funktsiyasini aniqlash mumkin bo'lsa-da maxsus , tez-tez tanlov funktsiyaning kerakli xususiyatlari bilan belgilanadi (masalan qavariqlik ) yoki u modeldan kelib chiqqanligi sababli (masalan, ehtimollik modelida modelning) orqa ehtimollik teskari xarajat sifatida ishlatilishi mumkin). Orqaga targ'ib qilish Asosiy maqola: Orqaga targ'ib qilish Backpropagation - bu o'rganish paytida topilgan har bir xato o'rnini qoplash uchun ulanish og'irliklarini sozlash usuli. Xato miqdori ulanishlar orasida samarali ravishda bo'linadi. Texnik jihatdan, backprop hisoblaydi gradient (lotin) ning xarajat funktsiyasi og'irliklarga nisbatan berilgan holat bilan bog'liq. Og'irlikni yangilash orqali amalga oshirilishi mumkin stoxastik gradient tushish yoki boshqa usullar, masalan Ekstremal o'quv mashinalari , [48] "Yoqilg'i yo'q" tarmoqlari, [49] orqaga qaytmasdan mashq qilish, [50] "vaznsiz" tarmoqlar, [51] [52] va konnektistik bo'lmagan neyron tarmoqlar . Paradigmalarni o'rganish Uchta asosiy o'rganish paradigmalari nazorat ostida o'rganish , nazoratsiz o'rganish va mustahkamlashni o'rganish . Ularning har biri ma'lum bir o'quv vazifasiga mos keladi Nazorat ostida o'rganish Nazorat ostida o'rganish juftlashtirilgan kirish va kerakli natijalar to'plamidan foydalanadi. O'quv vazifasi har bir kirish uchun kerakli natijani ishlab chiqarishdir. Bunday holda xarajat funktsiyasi noto'g'ri ajratmalarni yo'q qilish bilan bog'liq. [53] Odatda ishlatiladigan narx bu o'rtacha kvadratik xato , bu tarmoq chiqishi va kerakli chiqish o'rtasidagi o'rtacha kvadratik xatoni minimallashtirishga harakat qiladi. Nazorat ostida o'rganish uchun mos vazifalar naqshni aniqlash (shuningdek, tasnif deb ham ataladi) va regressiya (funktsiyani yaqinlashtirish deb ham ataladi). Nazorat ostidagi ta'lim ketma-ket ma'lumotlarga ham tegishli (masalan, qo'lda yozish, nutq va imo- ishoralarni aniqlash ). Buni "o'qituvchi" bilan o'rganish, shu vaqtgacha olingan echimlar